ماژول اول : آشنایی با مفاهیم اولیه هوش تجاری و نصب و راهاندازی ابزارها

ماژول دوم : آشنایی با انباره داده و اصول طراحی آن

ماژول سوم : آشنایی با ETL و استفاده از SSIS در SQL Server

ماژول چهارم : آشنایی با OLAP و استفاده از SSAS در SQL Server

ماژول پنجم : آشنایی با ساخت داشبورد و گزارشها

هـــــــوش تجـــــــاری - Enterprise BI

از داده تا تصمیمگیری با SQL Server

طول دوره: ۴۵ ساعت (۱۵ جلسه ۳ ساعته)

استاد: مسعود طاهری

نوع ارائه: حضوری - آنلاین

پرسش و پاسخ: هرجلسه بهصورت حضوری + گروه پشتیبانی

پشتیبانی: گروه تلگرامی اختصاصی

مدرک شرکت در دوره: انگلیسی

پیشنیاز شرکت در دوره: حداقل ۲ سال سابقه کار در حوزه SQL Server

تاریخ شروع دوره: از ۳۰ دی - یکشنبهها - ساعت ۱۷:۳۰ الی ۲۰:۳۰

محل برگزاری دوره: تهران، یوسف آباد، میدان فرهنگ، خیابان سی و سوم، پلاک ۲۹، طبقه دوم

طول دوره: ۴۵ ساعت (۱۵ جلسه ۳ ساعته)

استاد: مسعود طاهری

نوع ارائه: حضوری - آنلاین

پرسش و پاسخ: هرجلسه بهصورت حضوری + گروه پشتیبانی

پشتیبانی: گروه تلگرامی اختصاصی

مدرک شرکت در دوره: انگلیسی

پیشنیاز شرکت در دوره: حداقل ۲ سال سابقه کار در حوزه SQL Server

تاریخ شروع دوره: از ۳۰ دی - یکشنبهها - ساعت ۱۷:۳۰ الی ۲۰:۳۰

محل برگزاری دوره: تهران، یوسف آباد، میدان فرهنگ، خیابان سی و سوم، پلاک ۲۹، طبقه دوم

۳۰% تخفیف

ثبتنام دوره

حضوری:

۱۵,۵۰۰,۰۰۰ تومان

۱۰,۸۰۰,۰۰۰ تومان

آنلاین:

۱۱,۹۰۰,۰۰۰ تومان

۸,۳۰۰,۰۰۰ تومان

۳۰% تخفیف

ثبتنام دوره

حضوری:

۱۵,۵۰۰,۰۰۰ تومان

۱۰,۸۰۰,۰۰۰ تومان

آنلاین:

۱۱,۹۰۰,۰۰۰ تومان

۸,۳۰۰,۰۰۰ تومان

مزایای دوره های نیک آموز

کاملاً کاربردی

دورههای نیک آموز نزدیکترین سرفصل به بازار کار را دارند.

اساتید مجرب

اساتید دورههای نیک آموز، متخصصین با رزومه اجرایی قوی هستند.

شبکه سازی

ارتباط با سایر شرکتکنندگان و توانایی تعامل

مثالهای متنوع

در دورههای نیک آموز، تمارین و مثالهای متنوعی اجرا میشوند.

پرسش و پاسخ

دسترسی همزمان به استاد برای پرسش و پاسخ سریع

دانلود فایلها

دسترسی به کلاس، در هرشرایط زمانی و مکانی

سرفصلهای آموزشی

سرفصلهای دوره

۴۵ فصل

۱۵ جلسه

۴۵ ساعت

۱

لیست ماژولهای آموزشی دوره

۲

ماژول اول: آشنایی با مفاهیم اولیه هوش تجاری

۱- معرفی جایگاه BI در سازمانها

۲- چرخه تصمیم گیری

۳- پیش نمایش یک سیستم BI و یک پروژه BI

۴- آشنایی با انواع سرویسهای BI

۵- آشنایی با Technology Providerحوزه BI

۶- آشنایی با اجزاء و مسیر اجرای یک پروژه BI

هوش تجاری مجموعهای از ابزارها، برنامههای کاربردی و شیوههای کسب و کار است که هدف آن کمک به بهبود کسب و کار میباشد.

۳

ماژول اول: آشنایی با اجزاء یک پروژه هوش تجاری

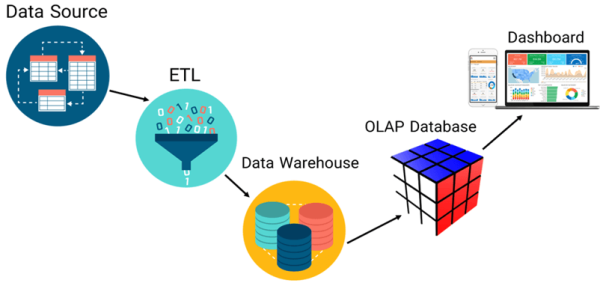

۱- بررسی مفهوم OLTP و مفهوم اولیه OLAP

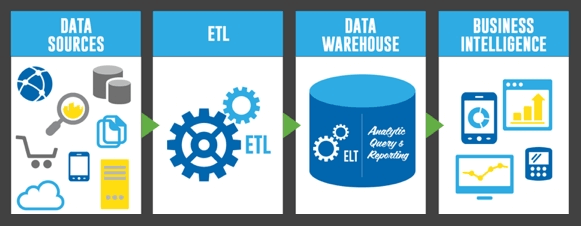

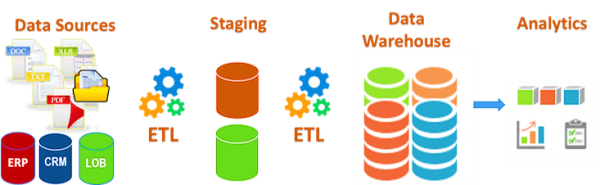

۲- بررسی اولیه مسیر اجرای یک پروژه BI و انباره داده (Data Warehouse) و مشاهده یک نمونه انباره داده

۳- بررسی اولیه فرآیند ETL و مشاهده یک پروژه ETL و مفهوم بانک اطلاعاتی تحلیلی و مشاهده یک OLAP Database

۴- بررسی اولیه داشبورد و گزارش و مشاهده نمونههایی از داشبوردها

برای این که بتوانید یک پروژه BI را به سرانجام برسانید باید با اجزاء آن آشنا باشید. لایههای اصلی که در یک پروژه BI نقش دارند عبارتاند از:

» لایه منابع اطلاعاتی

» لایه یکپارچهسازی

»لایه انباره داده

» لایه بانک اطلاعاتی تحلیل

» لایه داشبورد و گزارش

۴

ماژول اول: نصب و راهاندازی SQL Server و ابزارهای توسعه یک پروژه هوش تجاری

-

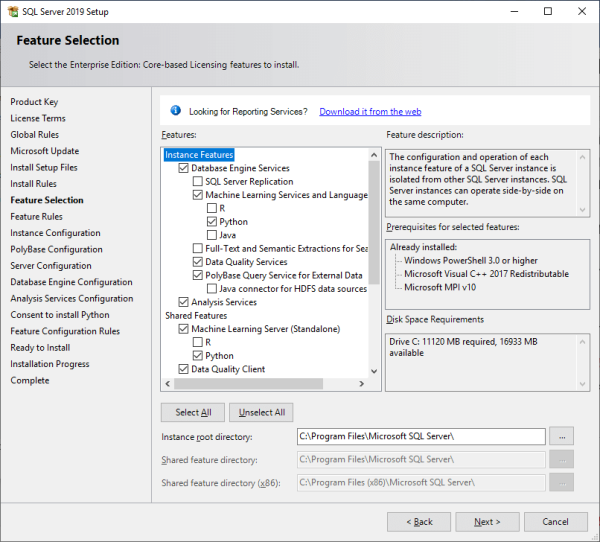

۱- معرفی اولیه پیشنیازهای نصب SQL Server 2022

۲- معرفی اولیه سرویس Database Engine ،SSIS و SSASما در طی این دوره هدفمان این است که توسعه یک پروژه Enterprise BI را با استفاده از تکنولوژیهای مایکروسافتی انجام دهیم. برای این که بتوانیم این کار را انجام دهیم، باید با ابزارهای ارائه شده توسط مایکروسافت آشنا شویم تا بتوانیم این کار را به بهترین نحو ممکن انجام دهیم. در طی این دوره شما با ویژگیهای کاربردی مربوط به این ابزارها آشنا خواهیم کرد.

۵

ماژول اول: نصب و راهاندازی ابزارهای کلاینت برای توسعه هوش تجاری

۱- معرفی ابزار SQL Server Management Studio و بررسی نحوه نصب و بهروزرسانی آن

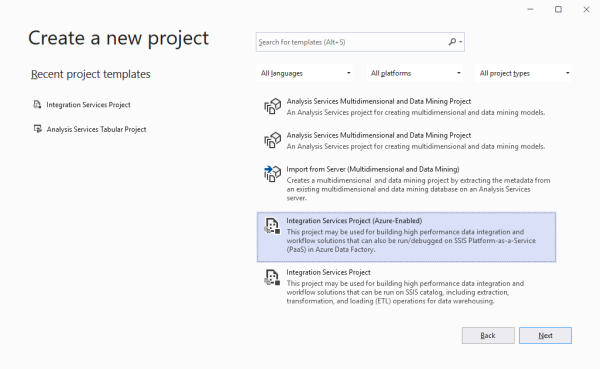

۲- معرفی ابزار Visual Studio 2022

۳- نحوه نصب Data Tools 2022

۴- بررسی نصب Extension مربوط به SSIS ،SSAS ،SSAS

۵- بررسی روال Update کردن Extensionهای مربوط به BI در Data Tools

یکی از ابزارهای کاربردی برای توسعه پروژههای BI استفاده از Visual Studio است. ما در طی این دوره با استفاده از VS 2022 و نصب Extensionهای BI یاد میگیریم که چگونه پروژههای ETL، OLAP و… را ایجاد نماییم.

۶

ماژول اول: نصب و راهاندازی بانکهای اطلاعاتی آموزشی و آشنایی با انباره داده

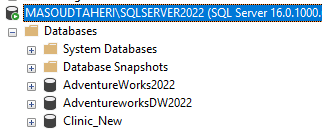

۱- آشنایی اولیه با انواع دیتابیس های SQL و NoSQL

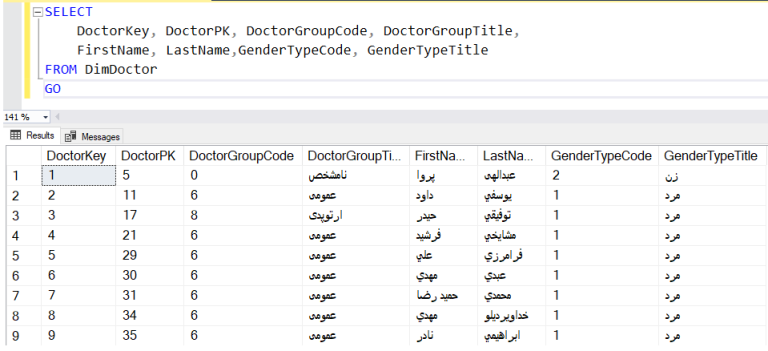

۲- بررسی بانک اطلاعاتی ClinicDW, AdventureworkDW, Adventurework

۳- بررسی نحوه بازیابی بانکهای اطلاعاتی در SQL Server

ما برای این که بتوانیم مسیر آموزشهای مربوط به مباحث انباره داده (Data Warehouse) و همچنین بانک اطلاعاتی تحلیلی (OLAP) را به طور مناسب جلو ببریم نیاز به تعدادی بانک اطلاعاتی مثال داریم. این بانکهای اطلاعاتی در طی این دوره به دانشجویان ارائه میگردد تا بتوانند مباحث مطرح شده در دوره را با آن تمرین نمایند.

۴- بررسی Data Warehouse و دلیل ایجاد آن

۵- بررسی اصول طراحی انبار داده

۶- هدف از ساخت انبار داده و جایگاه آن در یک پروژه BI

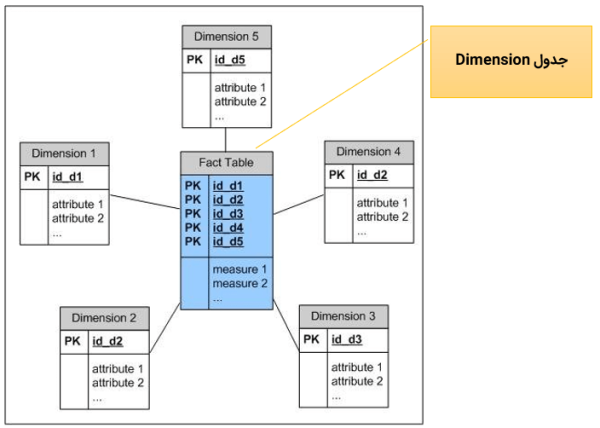

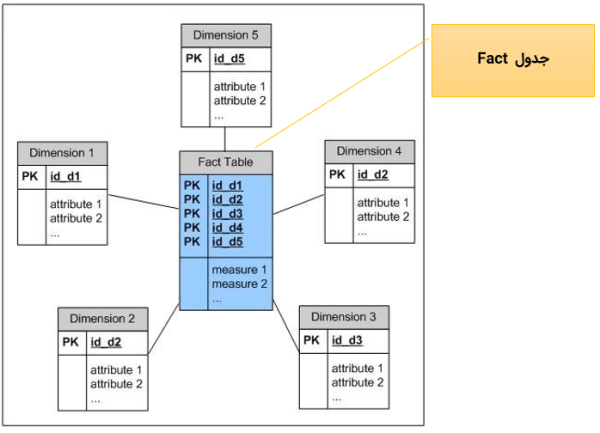

۷- آشنایی با انواع مدل سازی های پایگاه داده Relational و Multidimensional

۸- شناخت معماری های Inmon و Kimball

۹- شناخت مدل های Star, Snow Flake, Constellation در طراحی Multidimensional

۱۰- آشنایی با مفاهیم Fact و Dimension

۱۱- آشنایی با مفهوم Data Mart

۱۲- نحوه نگاشت یک Relational Data Model به Dimensional Data Model

۱۳- بررسی مدل سازی کلان انبار داده

۱۴- بررسی قواعد و استانداردهای حاکم بر طراحی انبار داده

۱۵- شناخت مفهوم ریزدانگی (Grain)

۱۶- طراحی جداول Dimension, Fact

۱۷- ساخت Bus Matrix

۱۸- مدل سازی داده ها

۱۹- شناخت مفهوم Schema در پایگاه داده

قلب تپنده یک پروژه BI انباره داده میباشد. ما دادههای جمع آوری شده در فاز ETL را در انباره داده قرار میدهیم تا بتوانیم از آن برای تحلیل استفاده نماییم.

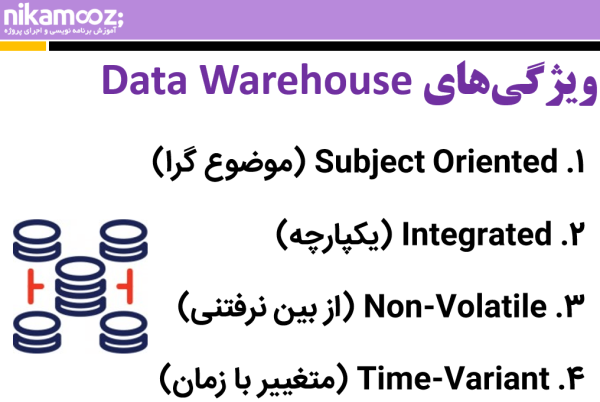

به طور کلی انباره داده یک بانک اطلاعاتی عادی است که به صورت D-Normal ایجاد شده که شامل

مجموعهای از دادههای موضوع گرا، یکپارچه، با متغییر زمانی و غیر فرار برای پشتیبانی از فرآیند تصمیمگیری مدیران میباشد.

۷

ماژول دوم: بررسی تخصصی اصول طراحی انباره داده

۱- شناخت انواع Dimension, Fact

۲- آشنایی با مفهوم Measure و انواع آن

۳- آشنایی با مفهوم Surrogate Key و Business Key

۴- آشنایی با مفهوم Slowly Changing Dimension (SCD) و بررسی روش های پیاده سازی SCD

۵- معرفی و آشنایی با Dimensionهای عمومی (DimDate , DimGeography و…)

۸

ماژول دوم: بررسی روشهای افزایش کارایی انباره داده در SQL Server

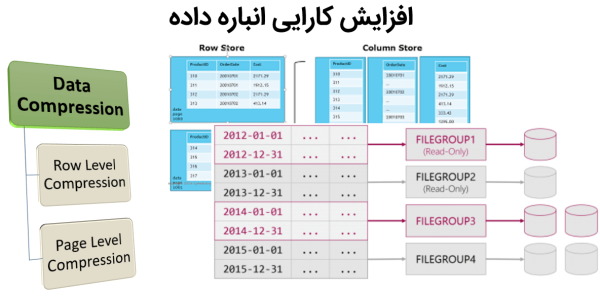

۱- بررسی Recovery Model و تاثیر آن بر روی Data Warehouse

۲- آشنایی با مفهوم File Group و ویژگیهای کلیدی آن

۳- بررسی تاثیر استفاده از File Group در کارایی Data Warehouse

۴- بررسی مفهوم ایندکس

۵- بررسی Clustered Index و Non Clustered Index

۶- بررسی مفهوم Data Compression و نحوه پیادهسازی آن در SQL Server

یکی از کارهایی که برای انباره دادههای بزرگ باید انجام داد انجام روالهای مربوط به Performance & Tuning میباشد.

در یکی از پروژهایی که درگیر آن هستیم یکی از جداول Fact مربوط به انباره داده دارای حجمی در حدود ۵ ترابایت است که در این جدول بیش از ۲۰ میلیارد رکورد قرار گرفته است. جهت افزایش کارایی مربوط به این جدول ما از Partitioning و Data Compression به صورت همزمان استفاده خواهیم کرد تا بتوانیم حجم جدول را کاهش داده و همچنین سرعت دستیابی به آن را بالا ببریم.

۹

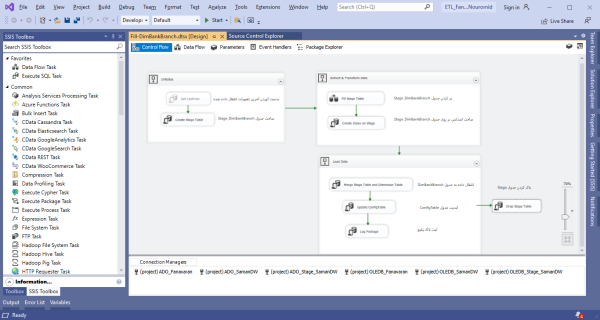

ماژول سوم: آشنایی با Data Tools و ایجاد یک پروژه SSIS

آشنایی با قسمتهای اساسی Data Tools برای کار با پروژههای SSIS

۱- آشنایی با قسمتهای اساسی Data Tools برای کار با پروژههای SSIS

۲- بررسی معماری یک پروژه SSIS

۳- آشنایی با مفهوم Task

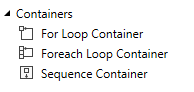

۴- بررسی نحوه گروهبندی Taskها در SSIS

۵- آشنایی با Import/Export Wizard در SQL Server

۶- معرفی Control Flow Task, Data Flow Task

۷- معرفی اولیه کامپوننتها در SSIS

۸- آشنایی با مفهوم Precedence Constraint در SSIS

برای پیادهسازی یک پروژه ETL باید از سرویس SSIS در SQL Server کنیم. ابزار توسعه یک پروژه ETL به سبک مایکروسافتی Visual Studio است که با نصب Extension مربوط به SSIS میتوانیم توسعه یک پروژه ETL را شروع کنیم.

۱۰

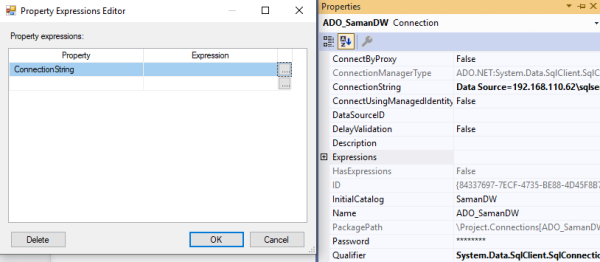

ماژول سوم: آشنایی با Connection در SSIS

۱- بررسی مفهوم Connection

۲- بررسی انواع Connectionها در SSIS

۳- معرفی OLEDB Connection در SSIS

۴- معرفی NET Connection در SSIS

۵- بررسی نحوه داینامیک کردن پارمترهای مربوط به Connectionها در SSIS

زمانی که شما بخواهید به منابع اطلاعاتی خود وصل شوید باید از مفهوم Connection استفاده کنید. یکی از کارهایی که میتوان در توسعه پروژههای ETL انجام داد داینامیک کردن Connection میباشد.

یادم است یک بار نیاز به انجام کاری تکراری و خواندن داده از چند بانک اطلاعاتی مشابه بود ما روال پیادهسازی مربوط به این کار را با استفاده Dynamic کردن Connectionها در SSIS توانستیم به خوبی انجام دهیم.

۱۱

ماژول سوم: پیاده سازی Monitoring و سلامت میکروسرویسها

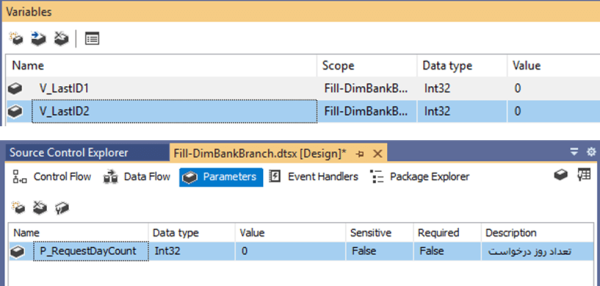

۱- بررسی نحوه کار با متغییرها در SSIS

۲- معرفی اولیه انواع Data Typeها در SSIS

۳- بررسی دامنه استفاده از متغییرها در Package

۴- بررسی نحوه مقدار دهی به متغییرها

۵- بررسی نحوه استفاده از متغییرها در کامپوننتهای SSIS

۶- بررسی Variable Scope در SSIS

۷- بررسی مفهوم پارامتر در پکیجها

۸- بررسی نحوه ایجاد Package Parameter در SSIS, Project Parameter در SSIS

در یکی از پروژههای BIیی که درگیر آن بودیم یکی از مشتریان درخواستی مبنی بر این داشت که واکشی دادههای منابع اطلاعاتی از X روز قبل اتفاق بیافته و همیشه سیستم ملاک واکشی را از X روز قبل انجام دهد. پارامتر X باید در اختیار مدیر سیستم باشد که بتواند آن در برخی مواقع تنظیم نماید. ما برای پیادهسازی این ویژگی از Package Parameter در SSIS استفاده کردیم.

۱۲

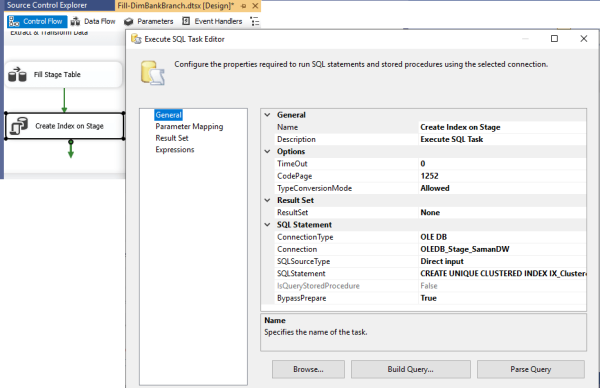

ماژول سوم: آشنایی با کامپوننتهای آماده سازی دادهها

۱- بررسی کامپوننت Bulk Insert Task ,Script Task ,Execute SQL Taskm ,Execute Process Task

۲- بررسی نحوه کار با متغییرها و پارامترها در کامپوننتهای اشاره شده در این بخش

۳- یکی از کامپوننتهای خیلی خوب در SSIS کامپوننت Execute SQL Task میباشد. ما بوسیله این کامپوننت میتوانیم دستورات SQL را در بانکهای اطلاعاتی مختلف اجرا کنیم. برای مثال فرض کنید که ما نیاز است پس از پر کردن یک جدول Stage ایندکس بر روی آن اعمال کنیم. برای این کار میتوانیم از این کامپوننت استفاده کرده و دستور ساخت ایندکس را بر روی جدول اعمال نماییم.

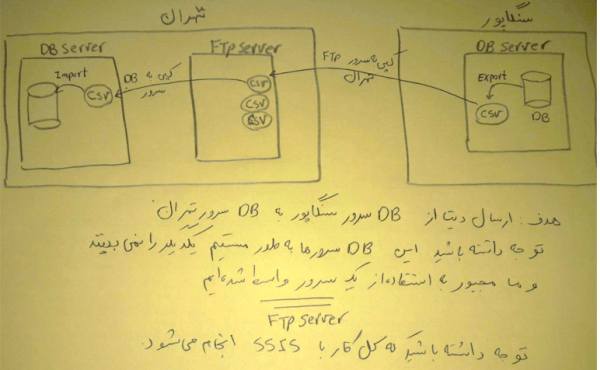

۴- بررسی کامپوننت File System Task ,Web Service Task ,FTP Task

چند سال پیش در یکی از پروژهایمان درگیر پیادهسازی یک روال ETL برای یک سازمان دولتی بودیم. در این سازمان یکی از سرورها در سنگاپور و دیگری در تهران قرار داشت هدف این بود که سرور تهران طی فواصل زمانی خاص بتواند اطلاعات موجود در برخی از جداول سرور سنگاپور را واکشی کرده و پس از انجام پروسه ETL درون Data Warehouse درج کند. اما مشکلی برای انجام اینکار وجود داشت سرور تهران نمیتوانست به طور مستقیم به سرور سنگاپور وصل شده و دادهها را از آن واکشی کند. برای اینکه مشکل را حل کنیم از یک FTP Server استفاده کردیم که هر دو سرور به طور مستقیم به آن دسترسی داشتند. سرور سنگاپور دادههای لازم را طی فواصل زمانی به صورت یک Flat File تولید کرده و در FTP Server قرار میدهد و پس از آن سرور تهران در زمانهایی خاص به FTP سرور وصل شده و فایلهای جدید را پس از انتقال به سرور تهران در سیستم Import میکند. تمامی این کارها بدون برنامه نویسی و با استفاده از SSIS انجام شده است.

۱۳

ماژول سوم: آشنایی با کامپوننتهای Containers

۱. چالشهای میکروسرویسها هنگام ارائه خدمات

۲. معرفی الگوی API Gateway

۳. وظایف اصلی در پیاده سازی API Gateway چیست؟

۴. چه چالشهایی را باید هنگام طراحی API Gateway مورد نظر قرار دهیم

۵. نصب و راه اندازی API Gateway به کمک Ocelot

۶. نصب و راه اندازی API Gateway با استفاده از Kong

۷. مقایسه ابزارهای موجود و مزایا و معایب آنها

۸. API Gateway خودمان را توسعه دهیم

۱۴

ماژول سوم: بررسی نحوه مدیریت خطا در Package و کار با Data Flow Task

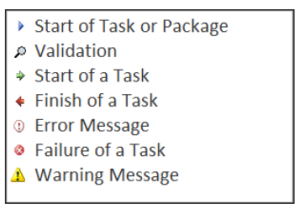

۱- آشنایی با انواع خطاها در SSIS

۲- بررسی نحوه کنترل خطا با استفاده از Precedence Task

۳- بررسی ویژگی Delay Validation در SSIS

۴- آشنایی با نحوه Debug کردن Packageها

۵- بررسی Event Handlerها و نحوه استفاده از آنها در SSIS

۶- بررسی نحوه پیادهسازی عملیات Logging در پکیجهای SSIS

۷- آشنایی با Catalog Logging در SSIS

در طی اجرای یک پکیج SSIS ممکن است پیامهایی در قالب هشدار، خطا، اطلاعرسانی و… تولید شود. ما در SSIS هنگام توسعه و همچنین در محیط عملیاتی میتوانیم جزئیات آنها را به همراه آیکونهای گرافیکی مربوط به مشاهده نماییم.

۱- معرفی Data Flow Task

۲- بررسی تنظیمات مربوط به افزایش کارایی هنگام استفاده از Data Flow Task

۳- بررسی روال ETL و کامپوننتهای درگیر در فاز ETL هنگام استفاده از SSIS

۴- معرفی کامپوننتهای اتصال به منابع اطلاعاتی

۵- بررسی کامپوننت Flat File Source ,OLEDB Source ,NET Source ,OLEDB Destination

۶- بررسی کامپوننت OLEDB Destination ,NET Destination ,Data Reader Destination ,Recordset Destination

۷- بررسی کامپوننت Data Streaming Destination ,ODATA

۸- بررسی نحوه استفاده از خروجی پکیجهای در Stored Procedure و Viewها در SQL Server

۹- بررسی نحوه پارامتریک کردن تنظیمات مربوط به کامپوننتهای اتصال به منابع اطلاعاتی

ما در این دوره با مفهوم ETL و روشها و تکنیکهای نقل و انتقال داده آشنا خواهیم شد. هر چقدر تسلط شما به کامپوننتهای SSIS بیشتر باشد به راحتی میتوانید سناریوهای ETL را طراحی و پیادهسازی نمایید. اتصال به منابع اطلاعاتی و چینش سناریوهای ETLی یکی از نکات قابل توجهی است که باید هنگام کار با SSIS به آن توجه داشت ما در طی این دوره شما را با این موضوع به خوبی آشنا خواهیم کرد.

۱۵

ماژول سوم: بررسی نحوه کار با Data Flow Task (بخش دوم)

۱- بررسی مفهوم Blocking در SSIS

۲- بررسی انواع حالتیهای مربوط به Blocking در SSIS

۳- معرفی کامپوننتهای Data Transformation (تبدیلات داده)

۴- معرفی کامپوننت Derived Column

۵- معرفی کامپوننت Aggregate Transformation

۶-معرفی کامپوننت Conditional Split

۷-معرفی کامپوننت Data Conversion

۸- معرفی کامپوننت Row Count

۹- معرفی کامپوننت Character Map

۱۰- معرفی کامپوننت Copy Column

۱۱- معرفی کامپوننت Audit

۱۲- معرفی کامپوننت Multi Cast

۱۳- معرفی کامپوننت Derived Column

زمانی که شما یک پکیج SSIS طراحی میکنید باید در استفاده از کامپوننتها دقت لازم را به خرج دهید برخی از کامپوننتهای موجود در Data Flow Task زمانی که با داده درگیر میشوند ماهیت Blocking داشته و باعث میشوند که حافظه سرور ETL بیش از حد مصرف شود. باید توجه داشت زمانی که حجم دادههای شما زیاد است از این کامپوننتها به صورت حریصانه استفاده نکنید. ما در طی این دوره شما را با مفاهیم مربوط به این حوزه به خوبی آشنا خواهیم کرد.

۱۶

ماژول سوم: بررسی نحوه کار با Data Flow Task (بخش سوم)

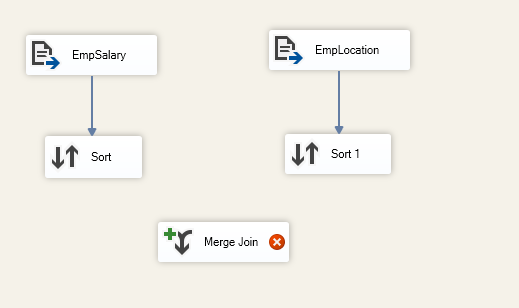

۱- معرفی کامپوننت Sort

۲- بررسی تاثیر مرتبسازی دادهها و مصرف حافظه در SSIS

۳- معرفی کامپوننت Lookup

۴- بررسی تنظیمات پیشرفته کامپوننت Lookup

۵- بررسی سناریوهای کاربردی قابل پیادهسازی با استفاده از کامپوننت Lookup

۶- معرفی کامپوننت OLEDB Command

۷- بررسی نوه فراخوانی Stored Procedureها با استفاده از کامپوننت OLEDB Command

۸- بررسی کامپوننت Import Column

۹- بررسی نحوه Import کردن دادههای Large Object به بانک اطلاعاتی با استفاده از Import Columns

۱۰- بررسی کامپوننت Export Column

۱۱- بررسی نحوه Export کردن دادههای Large Object از بانک اطلاعاتی با استفاده از Export Columns

یکی از کامپوننتهایی که در Data Flow Task میتوان از آن برای مرتبسازی دادهها استفاده کرد کامپوننت Sort میباشد. با استفاده از این کامپوننت علاوه بر مرتبسازی ما میتوانیم دادههای تکراری را نیز حذف نماییم. توجه داشته باشید که این کامپوننت به صورت کاملاً Blocking میباشد. این موضوع باعث خواهد شد که حافظه سرور شما بیش از حد مصرف شود.

۱۷

ماژول سوم: بررسی نحوه کار با Data Flow Task (بخش چهارم)

۱- معرفی کامپوننت Balanced Data Distributer

۲- بررسی نحوه افزایش سرعت عملیات ETL با استفاده از Balanced Data Distributer

۳- بررسی کامپوننت Union All ,Merge ,Script Components

۴- بررسی انجام عملیات تبدیل با استفاده از Script Components

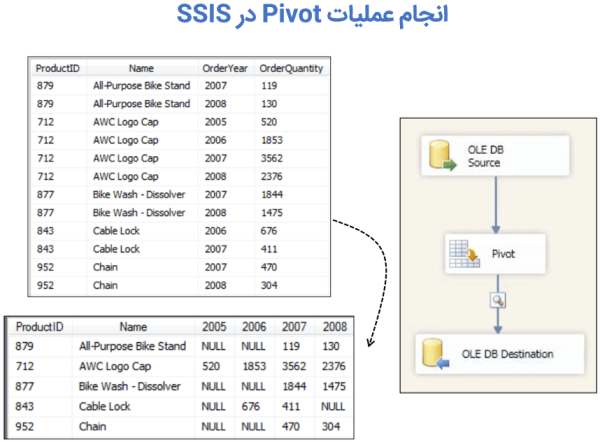

۵- بررسی نحوه استفاده از کامپوننت Pivot و Unpivot

یکی از کارهایی که در سناریوهای ETL ممکن است نیاز باشد چرخش داده میباشد. در برخی از موارد ما نیاز داریم ردیفهای دادهای را تبدیل به ستون و یا ستونهای دادهای را به ردیف تبدیل کنیم. برای این منظور ما میتوانیم از کامپوننتهای Pivot و Unpivot در SSIS استفاده کنیم. ما در این دوره شما را با نحوه استفاده از این کامپوننتها به خوبی آشنا خواهیم کرد.

۱۸

ماژول سوم: بررسی نحوه کار با Data Flow Task (بخش پنجم)

۱- بررسی نحوه استفاده از کامپوننت SCD

۲- بررسی نحوه پیادهسازی SCD Typeهای مختلف با استفاده از SSIS

۳- بررسی نحوه استفاده از کامپوننت SCD برای پُر کردن Dimensionها

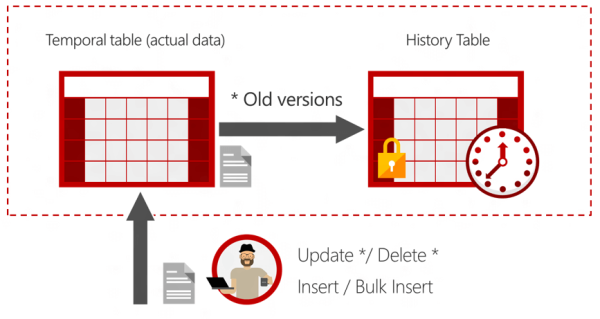

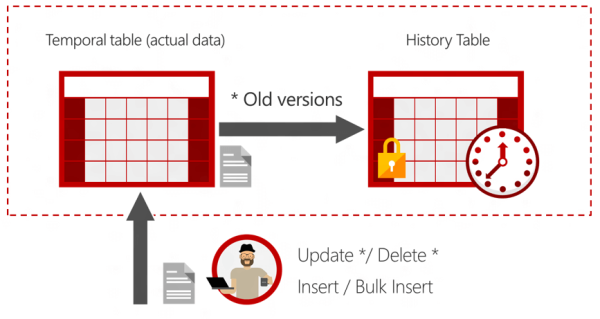

۴- بررسی نحوه استفاده از ویژگی Temporal Table

یکی از قابلیتهای جالب در SQL Server برای حفظ سوابق تغییرات جداول Fact و Dimension استفاده از Temporal Table میباشد، به طور خیلی ساده با استفاده از این امکان ما میتوانیم بدون انجام تغییراتی در Packageهای خود سوابق تغییرات رکوردها در جداول Fact و Dimension را به صورت خودکار در جداولی جداگانه جمع آوری کنیم.

۱۹

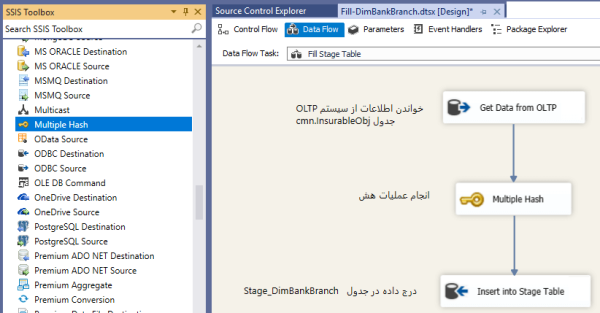

ماژول سوم: معرفی و نحوه نصب کامپوننتهای جانبی

۱- معرفی کامپوننت Multiple Hash

۲- معرفی کامپوننت Checksum Transformation

۳- معرفی کامپوننت Data Generator Source Adapter

۴- معرفی کامپوننت File Watcher Task

۵- معرفی کامپوننت RegexClean Transformation

۶- معرفی کامپوننت Row Count Plus Transformation

۷- معرفی کامپوننت Row Number Transformation

۸- معرفی کامپوننت Trace File Source Adapter

۹- معرفی کامپوننت Trash Destination Adapter

۱۰- معرفی کامپوننت Regular Expression Transformation

یکی از سوالات رایجی که خیلی از دوستان از ما میپرسند کامپوننتهای جانبی و نحوه استفاده از آنها در سناریوهای ETL میباشد. ما در طی این دوره شما را با تعدادی کامپوننت رایگان و کاربردی آشنا خواهیم کرد. یکی از آنها کامپوننت Multiple Hash میباشد که بوسیله آن میتوانیم عملیات Hash بر روی جریان داده را انجام دهیم.

۲۰

ماژول سوم: بررسی چالشهای تاریخ شمسی و دادههای فارسی در انباره داده

۱- بررسی DimDate شمسی

۲- بررسی نحوه ایجاد DimDate شمسی

۳- بررسی چالشهای مربوط به تبدیلات تاریخ شمسی

۴- بررسی چالشهای مربوط به تمیز کردن دادههای شمسی

استفاده از تاریخ شمسی در انباره داده یکی از نکاتی است که هنگام ایجاد آن باید در نظر داشته باشید. زمانی که شما با تاریخ شمسی و یا تاریخ میلادی در بانک اطللاعاتی عملیاتی درگیر میشوید نیاز دارید که با روشهایی مناسب (دارای سرعت بالا) تبدیلات لازم را انجام دهید.

ما در طی این دوره چالشهایی که شما در محیط عملیاتی در این خصوص به آن برخورد خواهید کرد را حل کرده و راهکارهایی به ازای آن به شما خواهیم داد.

۲۱

ماژول سوم: بررسی Stage Area و کاربرد آن

۱- Stage Area چیست؟

۲- دلایل استفاده Stage Area چیست؟

۳- محیط Stage Area را کجا باید ایجاد کنیم؟

۴- بررسی نقش Stage Area در افزایش سرعت ETL

۵- پیادهسازی یک مثال کاربردی ETL و استفاده از محیط Stage

۶- بررسی مفهوم کار با بانکهای اطلاعاتی به صورت Cross Database

۷- بررسی مفهوم کار با بانکهای اطلاعاتی به صورت Cross Server

یکی از تکنیکهایی که در انجام پروژههای ETL میتوان از آن استفاده کرد Stage کردن دادهها میباشد. با استفاده از این تکنیک ما میتوانیم دادهها را در یک فضای جدای از انباره داده ذخیره کرده و عملیات مختلف بر روی آن انجام دهیم. استفاده از این تکنیک باعث افزایش سرعت عملیات ETL میشود. ما در پروژههای خودمان از این تکنیک به خوبی استفاده میکنیم. برای نمونه با استفاده از این تکنیک ما میتوانیم عملیات Upsert در پروسه ETL را با سرعت بالا و به راحتی انجام دهیم.

۲۲

ماژول سوم: معرفی تکنیکهای کاربردی برای پر کردن جداول Dimension

۱- استفاده از تکنیک Merge

۲- استفاده از تکنیک Hash

۳- استفاده از تکنیک SCD

۴- بررسی پیادهسازی جداول Dimension به صورت Incremental Load

۵- بررسی پیادهسازی جداول Dimension به صورت Full Load

۶- بررسی نحوه استفاده از Timestamp در سیستمهای OLTP و تاثیر آن در پُر کردن جداول Dimension

جداول Dimension شامل دادههایی است که زاویه دید تحلیل در انباره داده شما را شامل میشود. ما برای پر کردن جداول Dimension روشهای مختلفی را در طی این دوره یاد میگیریم. مهمترین وجه تمایزی که این روشها نسبت به سایر روشهای دیگر دارد این است که رول ETL شما سریعتر بوده و این موضوع باعث کندی سرورهای عملیاتی شما نخواهد شد.

۲۳

ماژول سوم: معرفی تکنیکهای کاربردی برای پر کردن جداول Fact

۱- استفاده از تکنیک Merge

۲- استفاده از تکنیک Hash

۳- بررسی پیادهسازی جداول Fact به صورت Incremental Load

۴- بررسی پیادهسازی جداول Fact به صورت Full Load

۵- بررسی نحوه استفاده از Timestamp در سیستمهای OLTP و تاثیر آن در پُر کردن جداول Fact

جداول Fact شامل دادههایی است که تراکنشها و Measureهای تحلیلی در انباره داده شما را شامل میشود. ما برای پر کردن جداول Fact روشهای مختلفی را در طی این دوره یاد میگیریم. مهمترین وجه تمایزی که این روشها نسبت به سایر روشهای دیگر دارد این است که رول ETL شما سریعتر بوده و این موضوع باعث کندی سرورهای عملیاتی شما نخواهد شد.

۲۴

ماژول سوم: بررسی نحوه Deploy کردن Packageها در محیط عملیاتی

۱- آشنایی با کامپوننت Execute Package Task

۲- آشنایی Package Run All

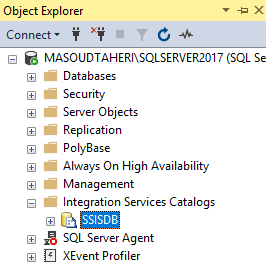

۳- آشنایی با نحوه پیکربندی Integration Catalog

۴- آشنایی با تنظیمات پیشرفته Integration Catalog

۵- بررسی تنظیمات Protection Level در پروژههای SSIS

۶- بررسی تاثیر تنظیمات Protection Level در محیط عملیاتی

۷- بررسی نحوه Deploy کردن پکیجها با استفاده از Wizard موجود در SSDT

۸- بررسی نحوه Deploy کردن پکیجهای با استفاده از فایل ispac

۹- بررسی نحوه اجرای پکیجها به صورت on-Demand

۱۰- بررسی نحوه اجرای پکیجها با استفاده از Job در SQL Server

در حال حاضر ما در سال ۲۰۲۳ هستیم و خیلی از دوستانی که با SSIS کار میکنند برای Deploy کردن Packageهای خود از روش قدیمی استفاده میکنند در این روش برای استفاده از پکیج در محیط عملیاتی فایل آن را بر روی سرور کپی کرده و یک Job مبتنی بر آن ایجاد میکنند.

در حال حاضر ما از SQL Server 2012 به بعد روش Deploy مبتنی بر Integration Catalog را مورد استفاده قرار میدهیم. در طی این روش کلیه فعالیتهای مربوط به پکیج در بانک اطلاعاتی SSIDB قرار دارد.

۲۵

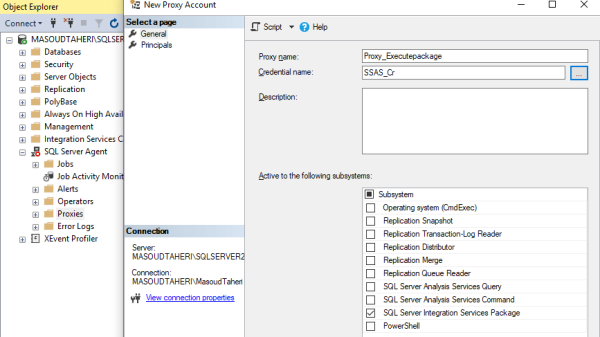

ماژول سوم: بررسی روشهای اجرای Packageهای SQL Server

۱- بررسی مفهوم Proxy در SQL Server

۲- بررسی سرویس Agent در SQL Server

۳- بررسی نحوه ایجاد Job برای اجرای اتوماتیک Packageهای ETL

۴- بررسی مفهوم Proxy در SQL Server

برای این که بتوانییم پکیجهای Deploy شده در محیط عملیاتی را با رعایت نکات امنیتی اجرا کنیم میتوانیم از Proxy در SQL Server استفاده کنیم. زمانی که شما از Proxy استفاده کنید پکیج مورد نظر شما با دسترسی Credential مورد استفاده در Proxy اجرا خواهد شد. در این حالت میتوانید کلیه تنظیمات امنیتی مورد نیاز را بر روی Credential مورد استفاده اعمال نمایید. ما در طی این دوره شما را با مفهوم Proxy، انواع آن و همچنین مفهوم Credential و نحوه تعریف و استفاده از آن در SQL Server آشنا خواهیم کرد.

۲۶

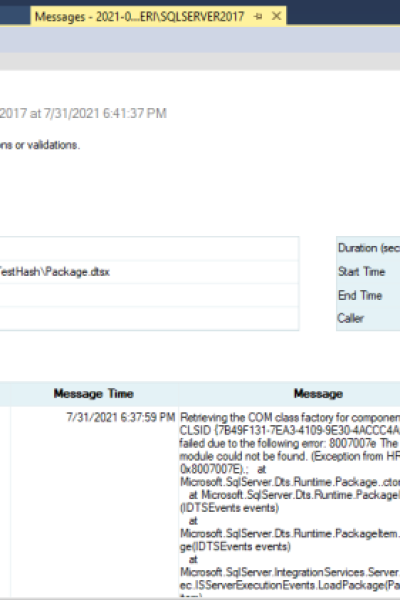

ماژول سوم: بررسی نحوه عیبیابی Packageها در محیط عملیاتی

۱- بررسی نحوه اجرای Reportهای مربوط به پکیجها

۲- بررسی نحوه استخراج لاگ اجرای پکیجها از Integration Catalog

۳- بررسی گزارش Performance مربوط به اجرای پکیجها

۴- بررسی نحوه رفع و رجوع مشکلات پکیجها در محیط Production

زمانی که شما مبنای Deploy پکیجهای SSIS را بر اساس Integration Catalog قرار میدهید میتوانید از لاگ اجرای پکیجها گزارش بگیرید. این گزارشها به صورت پیش فرض وجود داشت و به ما امکان عیب یابی و رفع مشکلات پکیجها را به خوبی میدهد.

۲۷

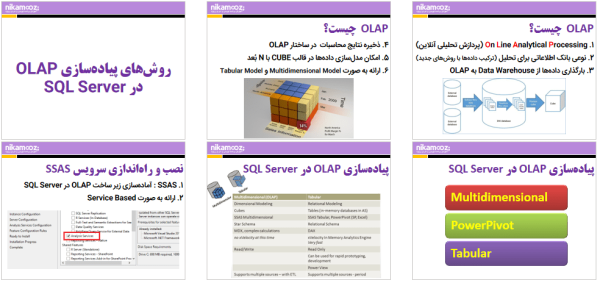

ماژول چهارم: معرفی OLAP

۱- آشنایی با OLAP Database

۲- بررسی اولیه معماری OLAP

۳- معرفی اولیه OLAP Multidimensional ,OLAP Tabular

۴- معرفی اولیه و بررسی تنظیمات اولیه سرویس OLAP

۵- آشنایی با مفاهیم اولیه OLAP (Cube , Attribute , Member ,…)

بانک اطلاعاتی تحلیلی یا OLAP یکی از ساختارهای ذخیرهسازی است که بوسیله آن نتایج محاسبات به ازای Dimensionهای مختلف در ساختاری خاص ذخیره میگردد. به طور خیلی ساده و عامیانه با ایجاد این حالت عملاً نتیجه محاسبات شما چون از قبل ذخیره شده است دادهها با سرعت بیشتری در اختیار شما قرار میگیرند.

۲۸

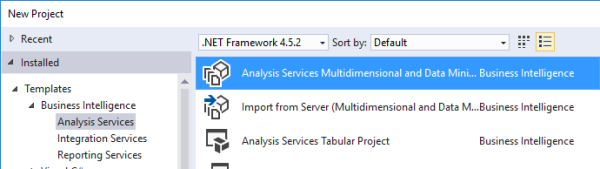

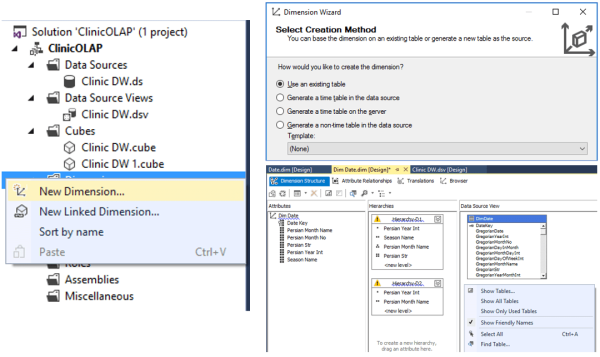

ماژول چهارم: ایجاد یک پروژه مبتنی بر OLAP Multidimensional

۱- بررسی نحوه استفاده از SQL Server Data Tools برای ایجاد یک پروژه Multidimensional

۲- آشنایی با قسمتهای مختلف یک پروژه OLAP Multidimensional

۳- آشنایی با مفهوم Data Source

۴- آشنایی با مفهوم Data Source View

۵- بررسی نحوه ساخت یک پروژه OLAP با استفاده از Wizard

۶- بررسی نحوه ساخت یک Relation

۷- بررسی نحوه ایجاد Named Query

۸- بررسی تغییر جداول و کوئریها در DSV

یکی از مدلهای توسعه OLAP ایجاد آن بر پایه تکنولوژی Multidimensional میباشد با استفاده از این نوع OLAP ما میتوانیم بانک اطلاعاتی تحلیلی خود را ایجاد کنیم. در طی این روش ساختار و دادههای بانک اطلاعاتی تحلیلی بر روی دیسک ذخیره خواهد شد.

۲۹

ماژول چهارم: کار با Dimensionها در یک پروژه OLAP (بخش اول)

۱- بررسی نحوه ایجاد Dimensionها در یک پروژه OLAP

۲- بررسی نحوه کار با Dimension Designer

۳- بررسی نحوه Browse کردن دادههای موجود در Dimension

۴- بررسی نحوه کار با برخی Propertyهای مربوط به یک Dimension

۵- بررسی نحوه ایجاد Hierarchy به صورت Flattened در Dimensionها

یکی از جذابیتهای OLAP استفاده از سلسله مراتبها است. ما با ایجاد سلسله مراتب در Dimensionها میتوانیم تحلیل را برای کاربر نهایی راحتتر کنیم. برای مثال اگر بخواهیم مقدار فروش را بر اساس سال، فصل، ماه و روز داشته باشیم کافی است که یک سلسله مراتب بر اساس موارد اشاره شده در DimDate ایجاد کنیم و تحلیل مقدار فروش را بر اساس آن داشته باشیم.

۳۰

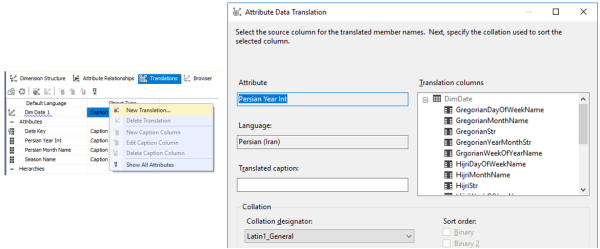

ماژول چهارم: کار با Dimensionها در یک پروژه OLAP (بخش دوم)

۱- بررسی نحوه ساخت Dimensionها Snow Flake

۲- بررسی استفاده از Role Playing Dimensionها

۳- بررسی Translation (ترجمه) Dimensionها

جداول Dimension شامل زاویه دید تحلیل در پروژههای OLAP میباشد. هنگامی که شما Dimensionهای خود را به پروژه اضافه میکنید باید حواستان به نوع Dimension باشد تا بتوانید از عهده چالشهای مربوطه در تحلیل برآیید.

۳۱

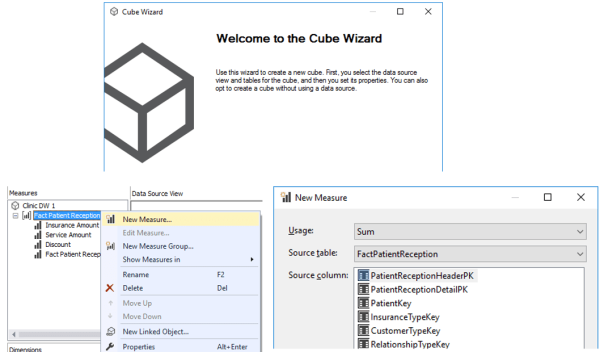

ماژول چهارم: کار با Cubeها در یک پروژه OLAP

۱- بررسی ساختار Cube

۲- بررسی نحوه ایجاد Cube

۳- بررسی نحوه ایجاد Measure

۴- بررسی نحوه ایجاد Measure Group

۵- بررسی Propertyهای مربوط به Cube

۶- بررسی Propertyهای مربوط به Measureها

زمانی که یک پروژه OLAPی ایجاد میکنید باید Measureها و همچنین Dimensionهای مورد نیاز را در Cube اضافه کنید تا پس از انجام عمیات Process نتیجه ارتباط بین Dimensionها و Measure Groupهای شما در Cube قرار گیرد. هنگام ایجاد Cube باید به نکات ریز و درشت زیادی توجه داشته باشید ما در طی این دوره شما را با این نکات آشنا خواهیم کرد.

۳۲

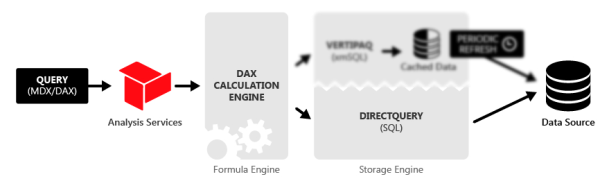

ماژول چهارم: استفاده از OLAP Tabular

۱- آشنایی با OLAP Tabular

۲- بررسی معماری OLAP Tabular

۳- مقایسه OLAP Tabular و Multidimensional

۴- بررسی نحوه ایجاد یک پروژه OLAP Tabular

۵- آشنایی با مفهوم Workspace در OLAP Tabular و Impersonation در OLAP Tabular

۶- بررسی نحوه Import کردن جداول در OLAP Tabular

۷- بررسی نحوه ایجاد Calculated Column

۸- آشنایی با DAX

۹- معرفی توابع پر کاربرد DAX

۱۰- بررسی مفهوم Context

۱۱- بررسی نحوه توسعه مژرها با استفاده از DAX

۱۲- ایجاد چند سناریو کاربردی برای نوشتن مژرها

۱۳- بررسی نحوه کار با توابع DAX برای تاریخ شمسی

۱۴- بررسی نحوه ایجاد Hierarchy

۱۵- بررسی نحوه پارتیشنبندی در OLAP Tabular

۱۶- بررسی نحوه استفاده از Direct Query در OLAP Tabular

۱۷- بررسی نحوه Deploy کردن پروژههای OLAP Tabular در محیط

۱۸- معرفی ابزار DAX Studio و بررسی نحوه استفاده از آن

ویژگی Direct Query معادل ROLAP در محیط Multidimensional است و به ما این امکان را می دهد که به صورت Live با Data Source در ارتباط باشیم.

۳۳

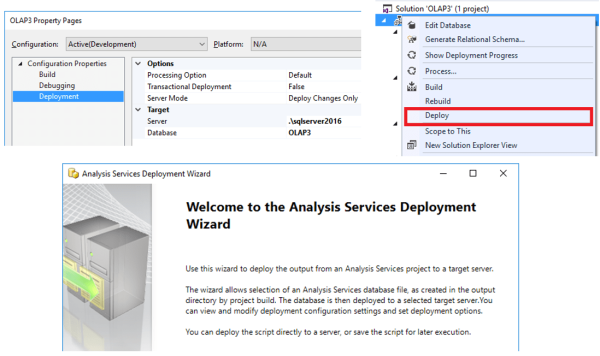

ماژول چهارم: بررسی نحوه Deploy و نحوه پردازش OLAP Database در محیط عملیاتی

۱- بررسی مفاهیم اولیه مربوط به پردازش Cube و OLAP Tabular

۲- بررسی مفهوم Build

۳- بررسی مفهوم Rebuild

۴- بررسی انواع تنظیمات مربوط به Process در Cube

۵- بررسی نحوه استفاده از Analysis Service

۶- بررسی ساختار فایل asdatabase

۷- بررسی انواع مدلهای پردازش Dimensionها (Process Full , Process Clear , Process Data ,…)

۸- استفاده از SSIS برای پیادهسازی روالهای پردازش OLAP Database

۹- استفاده از Analysis Services Processing Task در SSIS

۱۰- استفاده از Analysis Services Execute DDL Task در SSIS

۳۴

ماژول چهارم: انجام فعالیتهای Administration در OLAP

۱- آشنایی با دستورات XMLA

۲- بررسی نحوه انجام کارهای Administration مربوط به OLAP با استفاده از Wizard

۳- بررسی نحوه تهیه Backup از OLAP Database

۴- بررسی نحوه Restore کردن OLAP Database

۵- بررسی انجام تنظمیات پیشرفته SSAS

یکی از کارهایی که یک Admin خوب باید بر روی بانکهای اطلاعاتی OLAPی انجام دهید تهیه نسخه پشنتیبان از بانک اطلاعاتی میباشد. برای تهیه نسخه پشتیبان از بانک اطلاعاتی OLAPی میتوانیم از دستورات XMLA استفاده کنیم. چنانچه ما بخواهید این کار به صورت خودکار انجام شود میتوانید برای این کار از Job و یا پیکجهای SSIS استفاده کنید.

۳۵

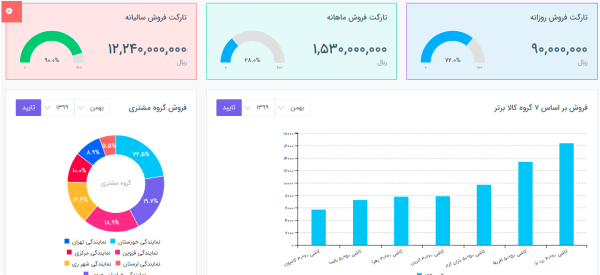

ماژول پنجم: بررسی اصول ساخت داشبورد و گزارش

۱- بررسی مفهوم Dashboard

۲- بررسی مفهوم Report

۳- بررسی تفاوت Dashboard و Report

۴- چه زمانی باید به سمت استفاده از Dashboard برویم؟

۵- چه زمانی باید به سمت استفاده از Report برویم؟

۶- بررسی اصول ساخت Dashboard

۷- بررسی اصول ساخت Report

۸- معرفی داشبوردهای موبایل و ابزارهای کاربردی برای ساخت آنها

۹- بررسی مفهوم پورتال برای نمایش داشبوردها و Reportها

برای این که بتوانید دادههای موجود در انباره داده، OLAP Database را به کاربران نمایش دهید باید خروجی کار را در قالب داشبورد و همچنین گزارش آماده نمایید. ایجاد داشبورد و همچنین گزارشها دارای روال و استانداردی خاص میباشد. ما در طی این دوره شما را با مفاهیم مربوط به این حوزه آشنا خواهیم کرد.

۳۶

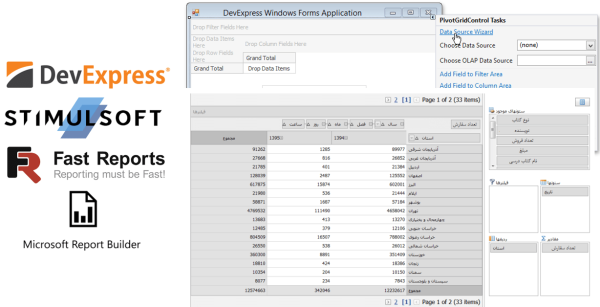

ماژول پنجم: معرفی برنامههای ساخت گزارش

۱- معرفی Fast Report

۲- معرفی Stimulsoft

۳- معرفی DevExpress

۴- معرفی Report Builder

برای ساخت و نمایش گزارش در برنامههای کاربردی ابزارهای مختلفی وجود دارد ما در طی این دوره چند ابزار خوب به شما معرفی خواهیم کرد تا بوسیله آن بتوانید دادههایی که در انباره داده ذخیره کردهاید را در قالب گزارش در Applicationهای خود به کاربران نمایش دهید.

۳۷

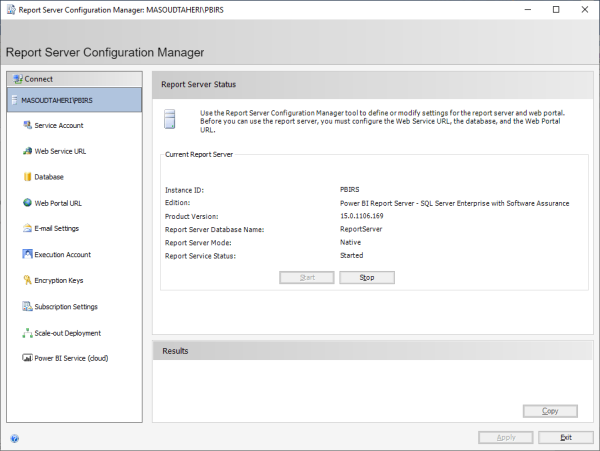

ماژول پنجم: استفاده از Power BI Report Server برای مدیریت گزارش و داشبورد

۱- بررسی تفاوت PBIRS با SSRS

۲- بررسی معماری PBIRS

۳- بررسی نحوه نصب و راهاندازی Power BI Report Server

۴- بررسی نکات مربوط به ارتقاء Power BI Report Server

۵- بررسی بانکهای اطلاعاتی ReportServer , ReportServerTemp

۶- بررسی تنظیمات کابردی مربوط به سرویس PBIRS

۷- بررسی برنامه Report Server Configuration Manager

۸- بررسی اجزاء مربوط به PBIRS

۹- بررسی پورتال PBIRS

۱۰- بررسی تنظیمات امنیتی PBIRS

۱۱- بررسی نحوه تعریف کردن لاگین و کاربر در پورتال

۱۲- بررسی نحوه تخصیص دسترسی به کاربران

مایکروسافت برای نمایش داشبوردها و گزارشها ابزاری به نام Power BI Report Server ارائه داده که مهمترین ویژگی بارز آن توانایی نمایش داشبوردهای تعاملی Power BI در صفحه وب میباشد. ما در این دوره نحوه نصب و راهاندازی PBIRS را بر روی یک سرور عملیاتی به شما یاد خواهیم داد و همچنین نحوه پیکربندی اصولی آن را به شما خواهیم آموخت.

۳۸

ماژول پنجم: استفاده از Report Builder برای ساخت گزارشها

۱- معرفی برنامه Power BI Report Builder

۲- بررسی نحوه ایجاد گزارش در SSDT

۳- بررسی مفهوم Credential و تنظیمات امنیتی مربوط به Connection

۴- بررسی مفهوم Data Source

۵- بررسی نحوه ساخت Shared Data Source

۶- بررسی تنظیمات امنیتی مربوط به Data Source

۷- بررسی مفهوم Dataset

۸- بررسی تنظیمات امنیتی مربوط به Dataset

۹- بررسی نحوه ایجاد یک Report ساده

۱۰- بررسی نحوه کار با Report Builder

۱۱- بررسی نحوه استفاده از Data Grid در Report Builder

۱۲- بررسی نحوه استافده از Matrix در Report Builder

۱۳- بررسی مفهوم Parameter

۱۴- بررسی نحوه ایجاد Dataset Parameter

۱۵- بررسی نحوه ایجاد Cascade Parameter

۱۶- بررسی نحوه Deploy کردن Reportها بر روی PBIRS

۱۷- بررسی نحوه اعمال تنظیمات امنیتی بر روی Reportها

با استفاده از نرم افزار Report Builder ما میتوانیم Paginated Report را ایجاد نماییم. برای مثال فرض کنید که شما نیاز دارید ریز خریدهای انجام شده در یک بازه زمانی یک ماه به ازای گروه کالاهای پوشاک را استخراج نمایید. برای این منظور میتوانید این گزارش را با استفاده از Report Builder طراحی نمایید و آن را در پورتال PBIRS منتشر کنید تا کاربران بتوانند به دادههای آن دسترسی پیدا کنند.

۳۹

ماژول پنجم: ساخت داشبوردهای تعاملی با استفاده از Power BI Desktop RS (بخش اول)

۱- معرفی Power BI

۲- معرفی اجزاء اصلی Power BI

۳- بررسی نحوه نصب و راهاندازی Power BI Desktop RS

۴- بررسی تفاوت Power BI Desktop و Power BI Desktop RS

۵- بررسی نحوه اتصال Power BI Desktop RS به Data Warehouse

۶- بررسی نحوه اتصال Power BI Desktop RS به OLAP

۷- بررسی تاثیر ویژوالها بر روی یکدیگر

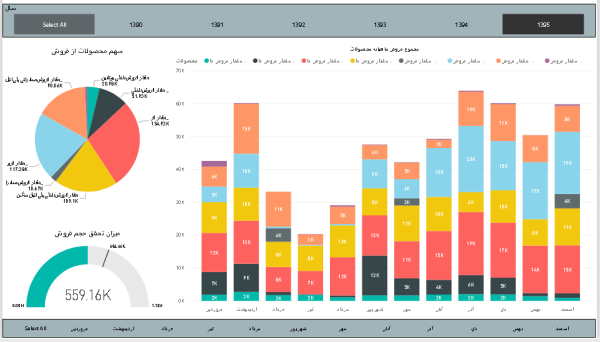

۸- بررسی استفاده از ویژوالهای مختلف در Power BI Desktop RS

۹- بررسی نحوه استفاده از Custom Visualها در Power BI Desktop RS

همه ما دوست داریم که بتوانیم داشبوردهایی حرفهای برای Visualize کردن دادهها تهیه کنیم. یکی از ابزارهایی که میتواند کمک خوبی در این خصوص به ما بکند Power BI است. قدرت اعجاب انگیز این نرمافزار به گونهای است که شما با چند کلیک کوچک در این نرمافزار میتوانید داشبوردهایی حرفهای را تولید کنید.

ما در طی این دوره شما را با این نرمافزار آشنا خواهیم کرد تا بتوانید داشبوردهای مدیریتی مناسب ایجاد کنید.

۴۰

ماژول پنجم: ساخت داشبوردهای تعاملی با استفاده از Power BI Desktop RS (بخش دوم)

۱- بررسی نحوه استفاده از نقشه در Power BI Desktop RS

۲- بررسی نحوه کار با تاریخ شمسی در داشبوردهای ایجاد شده با Power BI Desktop RS

۳- بررسی نحوه تاثیر Translation مربوط به Cube در اکسل

۴- بررسی نحوه Deploy کردن داشبوردهای Power BI Desktop RS بر روی PBIRS

۵- بررسی نحوه اعمال تنظیمات امنیتی بر روی داشبوردهای Power BI Desktop RS

برای ساخت یک داشبورد خوب باید امکانات موجود در پورتال PBIRS را بشناسید ما در طی این دوره امکانات این پورتال را به شما معرفی خواهیم کرد، تا بتوانید با استفاده از آن تنظیمات مختلفی بر روی داشبوردهای مدیریتی را انجام دهید.

۴۱

بررسی پروژه و سناریوهای کاربردی در مبحث هوش تجاری

بررسی پروژه و سناریوهای کاربردی در طراحی انبار داده

در انتهای دوره در سه حوزه و ماژول آموزشی انبار داده و ETL و OLAP و داشبورد به پیاده سازی پروژه های کاربردی و تمرین هایی می پردازیم.

در بخش ظراحی انبار داده به مدت ۳ ساعت در ابتدا نکات مهم در طراحی انبار داده را مرور خواهیم کرد سپس به پیاده سازی سناریوهای کاربردی در قالب تمرین و پروژه می پردازیم. از جمله:

۱- طراحی و پیاده سازی سیستم ابلاغ در آموزش و پرورش

۲- بررسی و طراحی سیستم حقوق و دستمزد

۳- طراحی انبار داده سیستم حسابداری

بررسی پروژه و سناریوهای کاربردی در بخش ETL

در بخش ETL به مدت ۲ ساعت در ابتدا باتوجه به آنچه آموخته اید نکات مهم در تشکیل جداول Fact و Dimension را مرور خواهیم کرد سپس به پیاده سازی سناریوهای کاربردی می پردازیم.

در این پروژه بانک اطلاعاتی یک شرکت فرضی در حوزه فروش مواد غذایی را با استفاده از بانک اطلاعاتی Northwind بررسی می کنیم. جدول Fact و Dimension را ایجاد می کنیم سپس با استفاده از مکانیزم Staging یک فضای موقت برای راحتی فرآیند ETL ایجاد می کنیم. و مراحل ETL را برای این بانک اطلاعاتی پیش می بریم. همچنین در این بخش برای پیاده سازی Load Incremental تمرین های کاربردی را برای شما در نظر گرفته ایم

بررسی پروژه و سناریوهای کاربردی در بخش OLAP و داشبورد

در بخش OLAP نیز با توجه به آنچه اموختهایم به ساخت OLAP بر روی بانک اطلاعاتی OLTP می پردازیم به سراغ بررسی بانک اطلاعاتی Northwind می رویم و به بررسی بانک اطلاعاتی یک شرکت فرضی در حوزه فروش محصولات غذایی دارای جداولی در حوزه فروش، محصولات، سفارشها و… می پردازیم. سپس پروژه OLAP را پیاده سازی می کنیم و به پردازش و Deploy کردن پروژه می پردازیم. به توسعه چند مژر میپردازیم و

در قدم بعدی به سراغ ساخت داشبورد و Deploy آن می رویم. و دسترسی مربوط به آن را ایجاد کرده و در انتها یک نسخه پشتیبان از بانک OLAP تهیه می کنیم.

استاد این دوره

مسعود طاهری

- مدرس و مشاور ارشد SQL Server & BI

- مدیر فنی پروژههای هوش تجاری (بیمه سامان، اوقاف، جین وست، هلدینگ ماهان و…)

- مدرس دورههــای SQL Server و هوشتجاری در شرکت نیکآموز

- نویسنده کتاب PolyBase در SQL Server

- مدرس و مشاور ارشد SQL Server & BI

- مدیر فنی پروژههای هوش تجاری (بیمه سامان، اوقاف، جین وست، هلدینگ ماهان و…)

- مدرس دورههــای SQL Server و هوشتجاری در شرکت نیکآموز

- نویسنده کتاب PolyBase در SQL Server

دانشجویان چه میگویند؟

با سلام این فیلم آموزشی برای هرکسی که در درگیر بانک اطلاعاتی باشد لازم و ضروریه، ساده و دقیق و قابل فهم توضیح داده شده . متشکرم از آقای طاهری

درود این دوره به جرات میتونم بگم بهترین دوره ای هست که تا بحال گذروندم. عملا با این دوره و تلاش فردی میتوان به یک متخصص هوش تجاری تبدیل شد تخصص و تدریس آقای طاهری هم که بی همتا هست خواستم تشکر ویژه داشته باشم. ممنون

با سلام و عرض ادب و احترام، بنده قسمت مربوط به دیتابیس رو مطالعه کردم و مثل همیشه بسیار با کیفیت و عالی بود. از زحمات استاد طاهری کمال تشکر را دارم.

با سلام خدمت تیم خوب نیک آموز و آقای طاهری عزیز واقعا کیفیت دوره از ۱۰۰ نمره ۱۰۰ رو می گیره.

سلام همان طور که انتظار داشتم... همین که اسم استاد طاهری رو کتاب هستش یعنی کیفیت کتاب بی نظیر و مطالبش فوق حرفه ای هست خیلی کتاب عالی هستش من واقعا لذت بردم ممنونم از گروه حرفه ای نیک آموز

با سلام و احترام خدمت اساتید محترم نیک آموز میخواستم تشکر کنم بابت این دوره بسیار کاربردی و خوبی که مجموعه شما در نظر گرفته بود . به شخصه دانش خیلی زیادی از نوع الگوریتم ها و اصول Performance ایی که باید رعایت کنیم یاد گرفتم و خیلی مفید بود برام و دوستانی که میخوان این دوره رو تهیه کنن یه نکته ایی رو در نظر داشته باشن که استاد طاهری بیس دوره رو بر اساس یکی از معروف ترین و اصولی ترین کتاب ها به اسم pro sql server internal در نظر گرفته و تو طول دوره بخش های زیادی از این کتاب بررسی میشه و یه دید کلی از کل Performance و نحوه کارکرد engine و الگوریتم ها به شما میده . تمامی مثال ها و چالش هایی که مطرح شده بسیار کاربردی بوده . پس اگه تو مجموعه تون در گیر چالش های Performance ایی هست حتما این دوره رو تهیه کنید و اصولی مباحث Performance tuning رو دنبال کنید . اساتید نیک اموز جزو درجه یک ترین اساتید کشور هستن و سعی میکنن همیشه بهترین ها رو ارایه بدن . موفق و موید باشید

سلام

من هم به نوبه خودم از زحمات شما کمال تشکر و قدردانی رو دارم.

مخصوصا از استاد عزیز، مهندس طاهری با تمام وجود سپاسگزارم که کلمه به کلمه ای که در دوره بیان فرمودن به دانش اندک ما افزود.

سلام و خسته نباشید خدمت شما استاد طاهری بزرگوار ضمن تشکر بابت انرژی فوق العاده ای که در حین آموزش میزارین

با سلام

میخواستم تشکر کنم از تدریس واقعا خوب استاد طاهری

من این دوره را تازه تهیه کردم واقعا راضی هستم

سلام همان طور که انتظار داشتم... همین که اسم استاد طاهری رو کتاب هستش یعنی کیفیت کتاب بی نظیر و مطالبش فوق حرفه ای هست خیلی کتاب عالی هستش من واقعا لذت بردم ممنونم از گروه حرفه ای نیک آموز

آقای طاهری در این حوزه بهترین هستند با کلام و آموزش شیرینسون. ممنون

با سلام خدمت تیم خوب نیک آموز و آقای طاهری عزیز واقعا کیفیت دوره از ۱۰۰ نمره ۱۰۰ رو می گیره.

۰۱

امکان ارتباط سریع و رو در رو با مدرس برای حل سوالات و ابهامات.

۰۲

دسترسی همیشگی به ویدیوهای ضبط شده

۰۳

دانلود مثال و تمرین

۰۴

ارائه مدرک معتبر پایان دوره

۰۵

پشتیبانی مستقیم و فعال در گروه تلگرامی

۰۶

امکان پرداخت اقساطی با اسنپ پی در ۴ قسط

۰۷

فرصت شبکهسازی و ارتباط حرفهای با سایر شرکتکنندگان

۰۸

حضور در کلاس و پذیرایی

۰۹

ارتباط مستقیم و رو در رو با مدرس

- ثبت درخواست اولیه، کاملاً رایگان است.

نمونه مدارک نیک آموز

پس از مشاهده و گذراندن دوره آموزش هوش تجاری Enterprise BI، یک مدرک اتمام دوره به شما تعلق میگیرد. این مدرک، بیانگر موفقیت شما در حل تمرینها و سناریوهای طراحی شده در دوره هوش تجاری Enterprise BI است و میتواند به عنوان یک گواهی کاربردی، سطح مهارتهای فنی و عملی شما در این حوزه اعتبار ببخشد. در بازار کار فعلی، دارا بودن مدرک دوره، به عنوان یک فاکتور مهم در حسن تمایز شما با سایر افراد تلقی میشود.

پس از مشاهده و گذراندن دوره آموزش هوش تجاری Enterprise BI، یک مدرک اتمام دوره به شما تعلق میگیرد. این مدرک، بیانگر موفقیت شما در حل تمرینها و سناریوهای طراحی شده در دوره هوش تجاری Enterprise BI است و میتواند به عنوان یک گواهی کاربردی، سطح مهارتهای فنی و عملی شما در این حوزه اعتبار ببخشد. در بازار کار فعلی، دارا بودن مدرک دوره، به عنوان یک فاکتور مهم در حسن تمایز شما با سایر افراد تلقی میشود.

سوالات متداول دوره آموزشی هوش تجاری Enterprise BI

پیش نیاز این دوره حداقل دو سال کار با SQL Server است.

یک نکته مهم جهت شفاف سازی، نیک آموز تنها موسسهای است که هم کار پروژهای در سطح ملی انجام میدهد و هم آموزشهای کاملا تجربی ارائه می کند. ما ۱۳ سال است که در کنار آموزش، پروژههای زیادی مانند هوش تجاری وزارت آموزش و پرورش، هوش تجاری سازمان اوقاف، هوش تجاری بیمه سامان، هوش تجاری هلدینگ ماهان (بانک گردشگری)، هوش تجاری مرکز آمار ایران و… را اجرا کردیم. این دوره با تدریس بینظیر مسعود طاهری همراه است که قرار است حاصل سالها تجربه اجرای خود در پروژههای هوش تجاری را ارائه نماید. شما در این دوره هم دانش یاد خواهید گرفت و هم تجربه یک مشاور درجه یک را همراه خود خواهید داشت.

پس قیمت این دوره نه تنها گران نیست بلکه بسیار هم ارزان است.

بله؛ این دوره آموزشی با محوریت مدل Tabular تدریس میشود. در مدل Tabular، دادهها در یک ساختار جدولی و بهطور معمول در پایگاه داده رابطه ای (RDBMS) ذخیرهسازی میشوند. این ساختار از سطرها و ستونها تشکیل شده است و به یک صفحه گسترده (Spreadsheet) شبیه است. در این ساختار، هر سطر نشاندهنده یک رکورد یا Fact است و هر ستون، یک بعد (Dimension) یا ویژگی (Feature) آن رکورد را نشان میدهد.

پس از مشاهده این دوره، میتوانید به مسیرهای شغلی مختلف حوزه هوش تجاری وارد شوید و در مسیر موفقیت در موقعیتهای شغلی گوناگونی همچون کارشناس هوش تجاری، BI Developer، معمار BI قدم بگذارید.

در بخش انبار داده در هوش تجاری مواردی، همچون طراحی و پیادهسازی سیستم ابلاغ در آموزش و پرورش، بررسی و طراحی سیستم حقوقودستمزد، طراحی انبار داده سیستم حسابداری و طراحی انبار داده برای بانک اطلاعاتی Northwind، بهعنوان پروژه کاربردی شرح داده میشوند.

در بخش ETL در هوش تجاری، طراحی فرآیند ETL برای بانک اطلاعاتی Northwind بهعنوان بانک اطلاعاتی یک شرکت فرضی در حوزه فروش محصولات غذایی موردبررسی قرار میگیرد و شما میتوانید بهواسطه این پروژه، تمامی فرآیندها را درک کنید.

در بخش OLAP و داشبورد در هوش تجاری، یک پروژه OLAP برای بانک اطلاعاتی Northwind ایجاد میشود. علاوهبراین، مواردی همچون ساخت داشبورد برروی بانک اطلاعاتی، استفاده از لاگین OLAPViewer بهمنظور دسترسی به OLAP و درنهایت، تهیه نسخه پشتیبان از OLAP Database ، همگی آموزش داده خواهند شد.

مسیر آموزش هوش تجاری، یک انتخاب ایدهآل برای توسعه مهارتها و تجربیات در حوزه هوش تجاری محسوب میشود. این مسیر آموزشی جامع، متشکل از چند دوره کاربردی و محوری حوزه BI است.

هوش تجاری و تحلیل داده، هردو از اجزای کلیدی فرآیند تصمیمگیری دادهمحور در سازمانهای مدرن هستند؛ اما ازنظر دامنه و اهداف، باهم تفاوت دارند.

در هوش تجاری، شامل از تکنولوژیها و متولوژیهایی برای تبدیل دادههای خام به بینشهای عملیاتی استفاده میشود و معمولاً این بینشها ازطریق گزارش، داشبورد و شاخص های کلیدی عملکرد (KPI) ارائه میشوند. درحالیکه تحلیل داده، فرآیندی است که برای بررسی، تفسیر و استخراج بینشهای معنادار از مجموعه دادهها استفاده میشود.

معمولاً در تحلیل داده، از تکنیکهای آماری و الگوریتمهای یادگیری ماشین استفاده میشود. ضمن اینکه هوش تجاری به هدف ارائه بینش برای تصمیمگیرندگان در سراسر سازمان استفاده میشود؛ درصورتیکه تحلیل داده، به درک عمیقتر الگوها و ترندهای داده برای آگاهی بخشی به تصمیمات استراتژیک و عملیاتی میپردازد.

بله؛ امکان استفاده از الگوریتمها و مدلهای یادگیری ماشین در هوش تجاری وجود دارد. در چنین سناریوهایی، انبار داده (DW | Data Warehouse) نقش کلیدی خواهد داشت؛ چراکه انبار داده بهعنوان یک زیربنا برای یکپارچهسازی الگوریتمها و مدلهای یادگیری ماشین در سیستمهای هوش تجاری عمل میکند.

ما با استفاده پلتفرم لحظه نگار پخش زنده را خواهیم داشت. شما در این پلتفرم محیط کلاس، صدا و دسکتاپ مدرس را بصورت زنده تماشا خواهید کرد.

شما بصورت چت آنلاین می توانید سوالات خود را بپرسید و مدرس هم سوالات شما را پاسخ خواهد داد. البته توجه داشته باشید که این پروسه پاسخگویی هر ۴۰ دقیقه یکبار خواهد بود تا مدرس رشته کلام از دستش خارج نشود. البته که گروه تلگرامی دوره در اختیار شما است و می توانید سوالات خود را آنجا هم مطرح کنید.

بلی. شما برای شرکت در کلاس و نصب نرم افزارهای مورد نیاز (اعلان خواهد شد) باید با خود لب تاپ همراه داشته باشید.

بلی، دسکتاپ و صدای مدرس رکورد خواهد شد و در پلیر اختصاصی اسپات پلیر به همراه کلید لایسنس ارائه خواهد شد. شما در سیستم عاملهای ویندوز، اندروید، آیفون (سیب، اناردون)، مک بوک میتوانید فیلم را مشاهده کنید.

بله، پس از اتمام دوره و گذراندن آزمون پایانی، گواهی معتبری به شما ارائه میشود که میتوانید آن را در رزومه خود ثبت کنید.

بله، امکان خرید اقساطی با اسنپ پی فراهم شده است. برای اطلاعات بیشتر میتوانید با تیم فروش یا در تماس باشید یا راهنمای خرید اقساطی دوره آموزشی با اسنپ پی را مطالعه بفرمایید.

این دوره به صورت دانلودی و دارای لایسنس پخش میباشد. شما میتوانید این دوره را در پلیر اختصاصی مجموعه، با نام اسپات پلیر مشاهده کنید. توجه کنید که پس از تهیه این دوره، یک کلید لایسنس منحصر به فرد در پنل کاربری شما قرار میگیرد. در صورتی که به لایسنسهای بیشتری نیاز داشته باشد، میتوانید با پرداخت هزینه آن از این مزیت برخوردار شوید. توجه کنید که تمام فایلهای مربوط به دوره، شامل سورس کدها و جزوات، همگی در اسپات پلیر قابل دسترس شما هستند. برای اطلاعات بیشتر، به صفحه راهنمای مشاهده محصولات آموزشی محافظت شده نیکآموز مراجعه کنید.

بله شما می توانید برای خرید این دوره از طریق فاکتور رسمی اقدام کنید. برای دریافت فاکتور رسمی، کافی است با بخش فروش تماس بگیرید.

شما میتوانید با مراجعه به فرم درخواست مشاوره تخصصی از متخصصان نیک آموز مشاوره دریافت کنید و با بهکارگیری مهارتهای تجربی تیم ما، در ارتباط با پروژههای تخصصی خود راهنمایی دریافت کنید.

بله؛ در نیک آموز امکان برگزاری دورههای سازمانی بهصورت تخصصی فراهم شده است. به منظور ثبت درخواست، کافی است اطلاعات خود و دوره سازمانی مدنظر را در فرم درخواست آموزش سازمانی ثبت کنید تا ما با شما تماس بگیریم.

رضایت شما از دوره آموزشی و کمک به رفع مشکلات احتمالی برای ما اهمیت زیادی دارد. به همین دلیل، یک گروه پشتیبانی در تلگرام ایجاد شده است تا شما بتوانید در صورت نیاز، مسائل خود را در این بستر مطرح کنید. تا حداکثر ۴۸ ساعت کاری پس از ثبت نام در دوره، با شما تماس گرفته میشود و فرآیند عضویت شما در گروه تلگرام نهایی خواهد شد. البته توجه شود که در آینده سیستم تیکتینگ راهاندازی میشود و فرآیند پشتیبانی از گروه تلگرامی به آنجا منتقل خواهد شد.

بله، شما میتوانید از مشاوره های نیکآموز به عنوان راهنما در مسیر خود استفاده کنید. برای این منظور لطفا شماره خود را در فرم مشاوره صفحه دوره وارد کنید تا مشاوران نیک آموز با شما تماس بگیرند.

۳۰% تخفیف

ثبتنام دوره

حضوری:

۱۵,۵۰۰,۰۰۰ تومان

۱۰,۸۰۰,۰۰۰ تومان

آنلاین:

۱۱,۹۰۰,۰۰۰ تومان

۸,۳۰۰,۰۰۰ تومان

سوالی دارید؟

پیش ثبت نام کلاس هوش تجاری آذر ۱۴۰۳

فیلد های "*" اجباری هستند

۳۰% تخفیف

ثبتنام دوره

حضوری:

۱۵,۵۰۰,۰۰۰ تومان

۱۰,۸۰۰,۰۰۰ تومان

آنلاین:

۱۱,۹۰۰,۰۰۰ تومان

۸,۳۰۰,۰۰۰ تومان

سوالی دارید؟

پیش ثبت نام کلاس هوش تجاری آذر ۱۴۰۳

فیلد های "*" اجباری هستند

کلیه حقوق این وبسایت متعلق به مجموعه نیک آموز میباشد.