نحوه برگزاری دوره: آنلاین

آموزش ساخت چتبات فارسی کاملا آفلاین

(چگونه با استفاده از LLM و RAG یک چت بات کاملا آفلاین و بدون نیاز به اینترنت بسازیم!؟)

این دوره با معرفی مبانی مدلهای زبانی بزرگ (LLM)، معماری ترنسفورمر و مکانیزم Self-Attention آغاز میشود و نحوه کنترل خروجی مدل (با پارامترهایی مانند Temperature و Top-p) و تکنیکهای پرامپتنویسی را آموزش میدهد. در پایان دوره به ساخت ایجنتهای هوشمند (Agents) تصمیمگیرنده با استفاده از ابزارهای سفارشی (Custom Tools) و مقدمهای بر سیستمهای چند ایجنتی (CrewAI) میپردازد و پروژههای پیشرفتهای مانند توصیف تصاویر (Multimodal) و Web Scraping را شامل میشود. در انتهای این دوره قادر خواهید بود یک چت بات کاملا آفلاین و بدون نیاز به اینترنت با استفاده از LLM و RAG بسازید.

اطلاعات دوره

معرفی دوره

در این دوره تخصصی، میآموزید که چگونه چتبات های فارسی کاملاً آفلاین را توسعه دهید. با مفاهیم بنیادی LLMها، معماری ترنسفورمر و تکنیکهای پیشرفته پرامپت انجینیرینگ آشنا میشوید. هسته اصلی دوره بر فریمورک قدرتمند LangChain و زبان LCEL متمرکز است. با راهاندازی مدلهای محلی (Ollama)، پیادهسازی سیستمهای پیچیده RAG برای پاسخگویی بر اساس اسناد و ساخت ایجنتهای هوشمند تصمیمگیرنده، مهارتهای حیاتی برای توسعه پیشرفتهترین سیستمهای چتبات فارسی را کسب کنید.

دسترسی همیشگی به محتوا دوره

همه کلاسها ضبط میشوند و در هر زمان برای تمامی دانشجویان، چه آنلاین و چه حضوری، در دسترس خواهند بود!

پشتیبانی مستمر

در گروه اختصاصی دوره، پاسخ سؤالاتتان را بگیرید، پیشتیبانی دریافت کنید و با دیگر شرکتکنندگان در ارتباط باشید!

مدرک معتبر پایان دوره

با تکمیل دوره، مدرک پایان دوره دریافت کنید و مهارتهای خود را رسمی کنید!

گروه پرسش و پاسخ

سوال بپرسید، تجربه به اشتراک بگذارید و از دیگران یاد بگیرید، همه در یک فضای آموزشی فعال!

محتوای کاربردی، یادگیری موثر

هر آنچه میآموزید، مستقیماً در پروژهها و کار واقعی قابل استفاده است!

جلسه اول رایگان

اولین جلسه را بهصورت آنلاین و رایگان تجربه کنید، سپس با خیال راحت برای ادامه مسیر تصمیم بگیرید!

این دوره برای چه افرادی مناسب است؟

مهندسان داده و یادگیری ماشین

توسعهدهندگان بکاند و نرمافزار

کارشناسان و متخصصان حوزه امنیت داده

پژوهشگران و دانشجویان ارشد هوش مصنوعی

مفاهیمی که یاد خواهید گرفت

- مبانی مدلهای زبانی (LLM) و معماری ترنسفورمر: درک مفاهیم بنیادی مانند توکنها، امبدینگها، مکانیزم Self-Attention و کنترل خروجی مدل با پارامترهای تولید متن (Temperature ,Top-k ,Top-p).

- پیادهسازی مدلهای آفلاین: نصب و راهاندازی مدلهای زبان بزرگ (مانند Llama 3 و Gemma) بهصورت محلی با استفاده از Ollama و تعامل با آنها از طریق کتابخانه پایتون,.

- توسعه رابط کاربری: ساخت رابط کاربری جذاب و سریع برای چتباتها با Streamlit و مدیریت تاریخچه مکالمات با استفاده از Session State.

- فریمورک LangChain و LCEL: تسلط بر هسته مرکزی LangChain Expression Language (LCEL) برای ساخت زنجیرههای پیچیده، استفاده حرفهای از Prompt Templates و ساختاردهی خروجی (JSON/Pydantic) با Output Parsers.

- پردازش اسناد (RAG): آمادهسازی اسناد ساختارنیافته (مانند PDF) با استفاده از Document Loaderها، استراتژیهای بخشبندی متن (Chunking) و پیادهسازی سیستمهای کامل RAG با پایگاه دادههای برداری (ChromaDB و FAISS) برای پاسخگویی بر اساس دانش خارجی.

- ایجنتهای هوشمند: ساخت ایجنتهای تصمیمگیرنده که میتوانند از ابزارهای جستجوی آماده یا ابزارهای سفارشی پایتون استفاده کنند (Tool Calling)، و همچنین ساخت سیستمهای چند ایجنتی (Multi-Agent Systems) با CrewAI.

- پروژههای پیشرفته: اجرای پروژههای چندرسانهای (مانند توصیف تصاویر با LLaVA و خلاصهسازی ویدیو با (Whisper) و انجام Web Scraping و تحلیل دادهها (مانند Resume Parser).

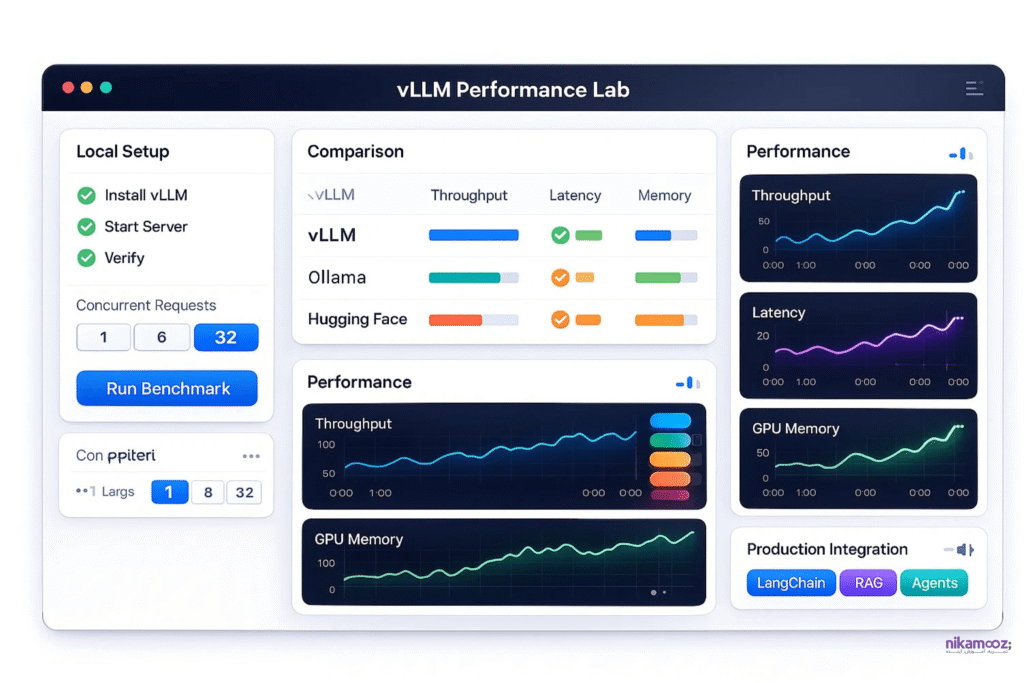

- بهینهسازی پروداکشن: آشنایی با vLLM برای افزایش سرعت اجرای همزمان مدلها و کاهش مصرف حافظه در محیطهای عملیاتی.

آشنایی پایه با مفاهیم هوش مصنوعی

تجربه کار با Linux یا Docker (ترجیحا)

آشنایی پایه با Web APIها

مدرس دوره

8 سال سابقه ی مدیر فنی در مجموعه دانش بنیان “شناسا”

توسعه دهنده پایتون و فعال در پروژه های بینایی ماشین با یادگیری عمیق

مشاور و منتور هوش مصنوعی در شتاب دهنده همتک، همراه اول، ایبیکام

مدرس دانشگاه شهید رجایی از سال ۱۳۹۴

ارائه ورکشاپ و تدریس در دانشگاه های صنعتی شریف، امیرکبیر و تهران

تجربه ی + 2000 ساعت تدریس مرتبط

سرفصلهای دوره

فصل اول: مبانی مدلهای زبانی و معماری ترنسفورمر

در این فصل، مدلهای زبان بزرگ (LLM)، معماری ترنسفورمر و مکانیزم Self-Attention معرفی میشوند. دانشجو مفاهیم پایهای چون توکنها، امبدینگها و تفاوت مدلهای Autoregressive و Encoder-Decoder را میآموزد. تمرکز اصلی بر اصول کنترل خروجی با پارامترهای تولید متن (مانند Temperature) و تکنیکهای پرامپت است.

مفاهیم پایه LLM:

- مدل زبانی چیست و کاربردهای آن.

- توکن و توکنایزیشن، مفاهیم امبدینگ.

معماری ترنسفورمر:

- مکانیزم Self-Attention و نقش آن در LLMها.

- ساختار Encoder و Decoder و تفاوت مدلهای autoregressive و encoder-decoder.

کنترل تولید متن:

پارامترهای مهم: Temperature ,Top-k ,Top-p و تأثیر آنها بر خروجی مدل.

تکنیکهای پرامپت:

Zero-Shot ,Few-Shot و مثالهای عملی

فصل دوم: مبانی، نصب و راهاندازی مدلهای محلی

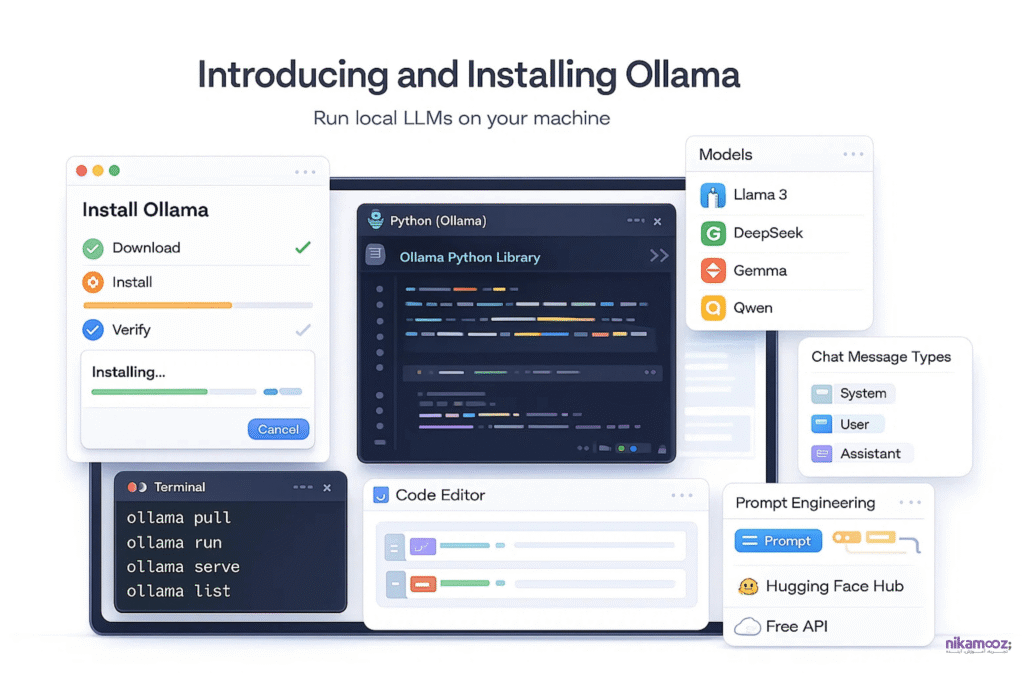

فصل پیش رو به شما کمک میکند تا مدلهای LLM را به صورت محلی راهاندازی کنید. این شامل نصب Ollama، کار با دستورات خط فرمان و اجرای مدلهای معروف است. محتوای این بخش تعامل با مدلها از طریق کتابخانه پایتون Ollama و آشنایی با مفاهیم اولیه Prompt Engineering و Hugging Face Hub را پوشش میدهد.

مقدمه و آمادهسازی محیط:

- معرفی و نصب Ollama برای اجرای مدلهای محلی.

- کار با دستورات خط فرمان Ollama (pull ,run ,serve ,list).

- اجرای مدلهای معروف(Llama 3 ,DeepSeek ,Gemma ,Qwen).

تعامل با LLM:

- استفاده از کتابخانه Ollama در پایتون.

- مفاهیم اولیه Prompt Engineering و انواع پیامها (System ,User ,Assistant).

- آشنایی با Hugging Face Hub و استفاده از APIهای رایگان آن.

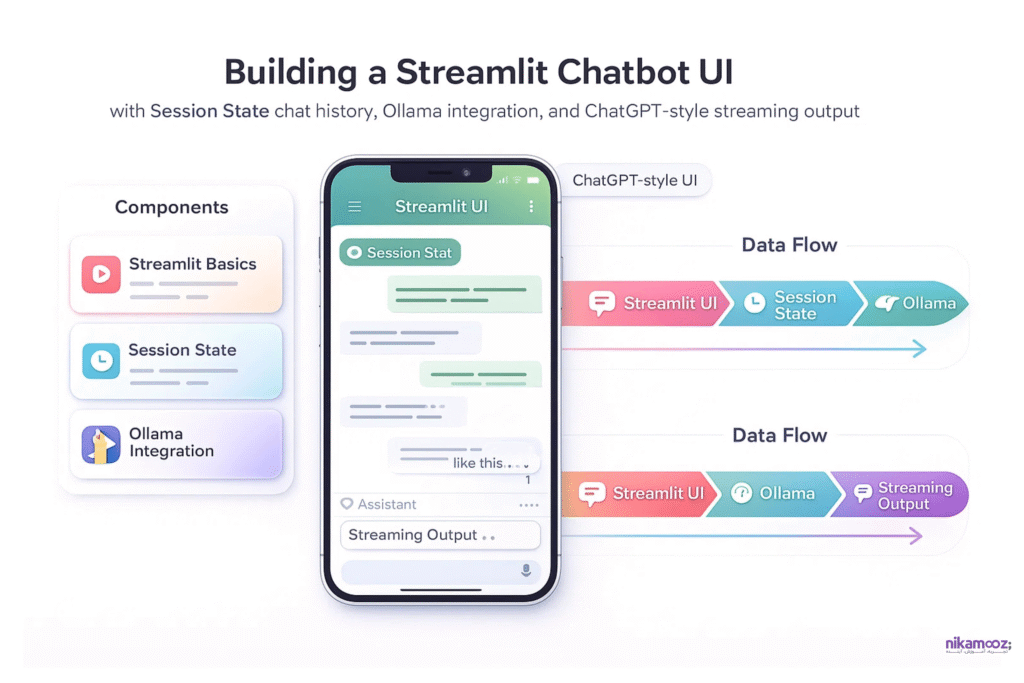

فصل سوم: رابط کاربری هوشمند با Streamlit

در این بخش، شما میآموزید که چطور یک رابط کاربری سریع و جذاب برای اپلیکیشنهای هوش مصنوعی بسازید. آموزش مبانی Streamlit، پیادهسازی قابلیت حفظ تاریخچه مکالمات با Session State و یکپارچهسازی با مدلهای Ollama از سرفصلهای مهم هستند. تمرکز بر توسعه یک Chatbot ساده و شبیهسازی خروجی Streaming شبیه به ChatGPT است.

- مبانی Streamlit برای ساخت اپلیکیشنهای هوش مصنوعی.

- ایجاد یک Chatbot ساده با قابلیت حفظ تاریخچه (Session State).

- یکپارچهسازی مدلهای Ollama با رابط کاربری Streamlit.

- شبیهسازی رابط کاربری ChatGPT (Streaming Output).

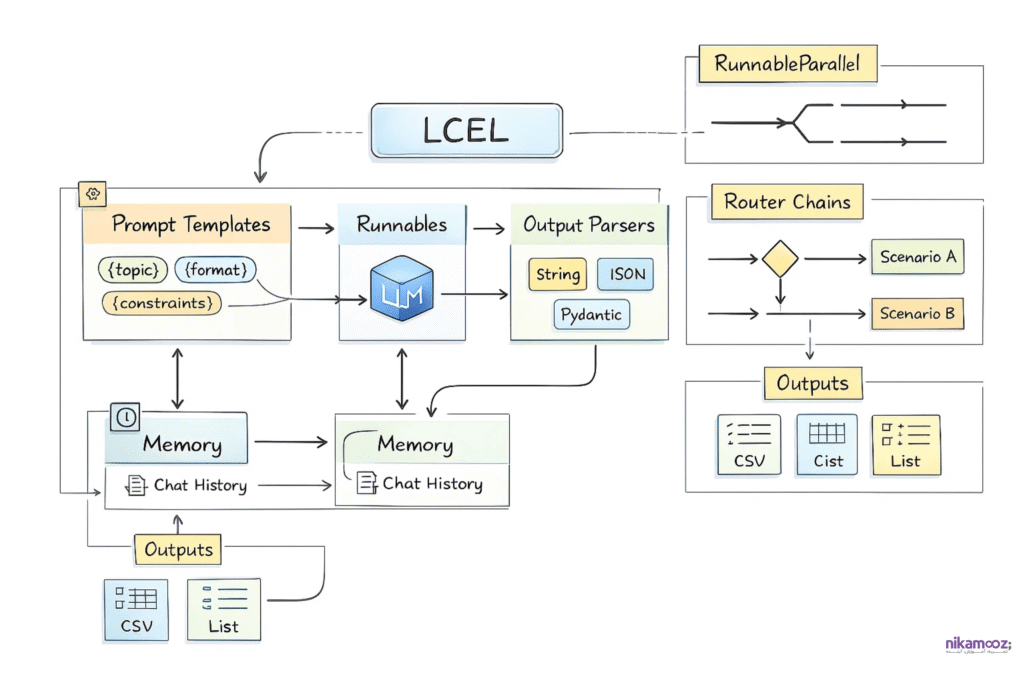

فصل چهارم: هسته مرکزی LangChain و LCEL

محتوای این فصل بر فریمورک LangChain و هسته آن یعنی LCEL متمرکز است تا زنجیرههای پیچیدهای از اجزای LLM بسازید. سرفصلها شامل مدیریت ورودی با Prompt Templates و ساختاردهی خروجی با Output Parsers (تبدیل به JSON/Pydantic) است. هدفنهایی، پیادهسازی جریانهای کاری پیشرفته (مانند مسیریابی) و استفاده از Memory برای تاریخچه مکالمات است.

مفاهیم پایه:

- مفهوم LCEL (LangChain Expression Language) و اهمیت آن.

- ساخت اولین Chain با استفاده از Runnables.

مدیریت ورودی و خروجی:

- استفاده حرفهای از Prompt Templates (مدیریت متغیرها)

- کار با Output Parsers:

- تبدیل خروجی به String.

- تبدیل خروجی به JSON و ساختارهای Pydantic (Structured Output).

- مدیریت خروجیهای CSV و لیستها

جریانهای کاری پیشرفته:

- اجرای Chainها به صورت موازی (Runnable Parallel).

- شرطیسازی و مسیریابی Chainها (Router Chains) برای سناریوهای مختلف.

حافظه (Memory):

- پیادهسازی Chat History در LangChain.

- ذخیره و بازیابی تاریخچه مکالمات.

فصل پنجم: پردازش اسناد و دادهها (Data Ingestion)

در فصل پیش رو، یاد میگیرید که چگونه اسناد و دادههای ساختارنیافته (مانند PDF) را برای LLM آماده کنید. این شامل استفاده از Document Loaderها و ابزارهایی چون Docling برای استخراج دادههاست. تمرکز بر رفع محدودیت Context Window از طریق فرآیند Chunking و استفاده از روشهای مؤثر مانند RecursiveTextSplitter است.

کار با Document Loaderها:

- بارگذاری فایلهای PDF (PyMuPDF) ,Word و Excel

- استفاده از MarkItDown و Docling برای تبدیل اسناد پیچیده به فرمت قابل فهم برای مدل.

- استخراج جداول و تصاویر از اسناد.

- استراتژیهای بخشبندی متن (Chunking):

- محدودیت Context Window و جلوگیری از فراموشی مدل.

- روشهای RecursiveTextSplitter.

فصل ششم: سیستمهای RAG (بازیابی اطلاعات و تولید متن)

این بخش به طور کامل به سیستمهای RAG (Retrieval-Augmented Generation) و نحوه غنیسازی پاسخهای LLM با دانش خارجی میپردازد. سرفصلها شامل درک Embedding، کار با Vector Stores (مانند ChromaDB و FAISS) و پیادهسازی کامل چرخه RAG است. تمرکز اصلی بر ساخت Chain نهایی RAG و تکنیکهای بهینهسازی آن است.

- مفاهیم Embedding و Vector Stores.

- کار با پایگاه دادههای برداری (ChromaDB وFAISS).

- پیادهسازی کامل چرخه RAG:

- ایندکس کردن اسناد.

- جستجوی تشابه (Similarity Search vs MMR).

- ساخت Chain نهایی برای پاسخگویی به سوالات از روی اسناد (PDF ,Text).

- بهینهسازی RAG و تکنیکهای پیشرفته (RAG Prompt Tuning).

فصل هفتم: ایجنتهای هوشمند (AI Agents) و ابزارها

در این فصل، شما از Chain به سمت ایجنتهای تصمیمگیرنده که میتوانند از ابزارها (Tools) استفاده کنند، حرکت میکنید. محتوا شامل مفهوم Tool Calling، استفاده از ابزارهای جستجوی آماده و ساخت ابزارهای سفارشی است. هدف این بخش، ساخت ایجنتهای پیشرفته در LangChain و معرفی CrewAI برای ایجاد سیستمهای چند ایجنتی (Multi-Agent Systems) است.

Tool Calling:

- آشنایی با مفهوم اتصال ابزار به LLM.

- استفاده از ابزارهای آماده (Search Tools: Tavily ,DuckDuckGo ,Wikipedia).

- ساخت ابزارهای سفارشی (Custom Tools) با پایتون.

ساخت Agent:

- تفاوت Chain و Agent.

- ساخت ایجنتهای تصمیمگیرنده با LangChain.

- مدیریت وضعیت ایجنت (State Management).

پروژه پیشرفته Agentic RAG:

ترکیب RAG با قابلیت جستجو و تصمیمگیری خودکار.

مقدمهای بر CrewAI:

ساخت سیستمهای چند ایجنتی (Multi-Agent Systems) برای سناریوهای پیچیده (مانند نوشتن داستان یا برنامهریزی سفر).

فصل هشتم: پروژههای کاربردی و چندرسانهای

فصل پیش رو دانش شما را در قالب پروژههای عملی و چندرسانهای (Multimodal) به کار میگیرد. سرفصلها شامل توصیف تصاویر با مدلهای Vision (مانند LLaVA) و پردازش ویدیو با Whisper است. تمرکز این بخش بر پروژههای تخصصی مانند Web Scraping & Analysis و ساخت یک Resume Parser برای تحلیل خودکار اطلاعات است.

پروژههای چندرسانهای (Multimodal):

- توصیف تصاویر با مدلهای Vision (مانند LLaVA).

- پردازش ویدیو و تبدیل گفتار به نوشتار (Whisper) برای خلاصهسازی ویدیو.

پروژههای تخصصی:

- Web Scraping & Analysis: استخراج داده از وب (مانند لینکدین) و تحلیل پروفایلها یا رزومهها با کمک LLM.

- Resume Parser: ساخت سیستم هوشمند تحلیل و استخراج اطلاعات از رزومه.

فصل نهم: بهینهسازی و اجرای سریع مدلها (vLLM)- (تدریس در صورت صلاحدید مدرس دوره با توجه به سطح علمی دانشجویان)

محتوای این فصل به طور کامل به بهینهسازی و افزایش سرعت اجرای مدلها اختصاص دارد. معرفی vLLM و کاربرد آن در سرعتبخشی و کاهش مصرف حافظه، هسته اصلی این بخش است. تمرکز بر مقایسه عملکرد vLLM در اجرای همزمان درخواستها و ادغام آن با LangChain برای بهینهسازی RAG و Agentها در محیط پروداکشن است.

- معرفی vLLM و کاربرد آن در سرعتبخشی و کاهش مصرف حافظه.

- آموزش نصب و راهاندازی vLLM در محیط محلی.

- مقایسه vLLM با اجرای استاندارد Ollama و مدلهای Hugging Face.

- نمونه عملی: اجرای چند درخواست همزمان با vLLM و بررسی Performance.

- ادغام vLLM با LangChain و استفاده در RAG و Agentها.

چارچوب برگزاری دوره

فرایند برگزاری و زمانبندی

نوع ارائه و هزینه دوره

ظرفیت باقیمانده: 30 نفر

محلبرگزاری: تهران، یوسفآباد، نیکآموز (مسیریابی)

امکان پرداخت 4 قسطه با

ظرفیت باقیمانده: 5 نفر

پلتفرم برگزاری: لحظهنگار

مشاهده دوره و پرسش و پاسخ آنلاین در بستر لحظهنگار

دسترسی آفلاین به ویدیوها در اسپاتپلیر

دانلود PDF پاورپوینت جلسات

دارای گروه پرسش و پاسخ تلگرامی

امکان پرداخت 4 قسطه با

دوره آموزش ساخت چتبات فارسی کاملا آفلاین

اگر هنوز برای ثبتنام قطعی تصمیم نگرفتهاید اما میخواهید ظرفیت خود را حفظ کنید، فرم زیر را تکمیل کنید. با توجه به محدودیت ظرفیت، اولویت با افرادی است که زودتر رزرو خود را انجام دهند.

"*" فیلدهای الزامی را نشان می دهد

از تجربه تا نتیجه!

شرکتکنندگان این دوره از دانشجویان کلاسهای استاد ارومند هستند و نظرات واقعیشان را درباره سبک تدریس و کلاسها میگویند. تجربههایشان را بشنوید و با اطمینان تصمیم بگیرید!

نمونه مدرک نیک آموز

مدرک نیک آموز نشاندهنده تخصص و مهارتی است که شما را برای موفقیت در آزمونهای استخدامی و پروژههای حرفهای آماده میکند. همچنین، شما میتوانید پس از دریافت مدرک، آن را مستقیماً به بخش Education پروفایل لینکدین خود اضافه کرده و رزومه خود را معتبرتر کنید

نمونه آموزشها

ویدیوهای زیر، نمونههایی از سبک تدریس و کلاسهای استاد ارومند هستند. با مشاهده آنها میتوانید با نحوه آموزش ایشان آشنا شوید و با اطمینان بیشتری برای شرکت در دوره تصمیم بگیرید.

شرکت در جلسه اول آنلاین این دوره رایگان میباشد، جهت ثبتنام کلیک کنید.

سوالات تخصصی دوره ساخت چتبات فارسی کاملا آفلاین

1. در این دوره واقعا با API سیستمهای Cloud کار نخواهیم کرد؟ یعنی بدون اینترنت و کاملا آفلاین؟!

بله، نام دوره به صراحت “ساخت چت بات فارسی کاملا آفلاین” است. تمرکز این دوره بر “نصب و راهاندازی مدلهای محلی” است تا بتوان مدلهای LLM را به صورت محلی راهاندازی کرد. در فصل دوم، ابزاری مانند Ollama برای اجرای مدلهای محلی معرفی و نصب میشود. آشنایی با Hugging Face Hub و استفاده از APIهای رایگان آن نیز ذکر شده است.

2. LLM چیست و از کدام مدلهای زبان در این دوره استفاده خواهیم کرد؟

LLM مخفف “مدلهای زبان بزرگ” است. این مدلها و مفاهیم پایهای مانند توکن و امبدینگ معرفی میشوند.

مدلهای معروفی که در این دوره اجرای آنها آموزش داده میشود شامل Llama 3 ,DeepSeek ,Gemma و Qwen هستند.

3. RAG چیست و چه کاربردی دارد؟

RAG مخفف “Retrieval-Augmented Generation” به معنای بازیابی اطلاعات و تولید متن است.

کاربرد سیستمهای RAG این است که پاسخهای مدلهای زبان بزرگ (LLM) را با استفاده از دانش خارجی غنیسازی کنند. در این دوره نحوه پیادهسازی کامل چرخه RAG برای پاسخگویی به سوالات از روی اسناد مانند (PDF و Text) آموزش داده میشود.

4. آیا میتوانیم با محتوای PDF یا Word فارسی سامانه چت بات آفلاین ایجاد کنیم؟

بله، این دوره با هدف ساخت “چت بات فارسی” ارائه شده است. در این دوره آموزش داده میشود که چگونه اسناد و دادههای ساختارنیافته را برای LLM آماده کنید. این شامل کار با Document Loaderها برای بارگذاری فایلهایی مانند PDF با استفاده از ((PyMuPDF) و Word) است. در نهایت، همچنین، ساخت Chain نهایی RAG برای پاسخگویی به سوالات از روی اسناد PDF و Text ذکر شده است.

5. در این دوره هاست کردن مدلهای زبانی بزرگ (LLM) آموزش داده خواهد شد؟

تمرکز اصلی دوره بر راهاندازی مدلها به صورت محلی است به موضوع بهینهسازی و اجرای سریع مدلها (vLLM) اختصاص دارد. معرفی vLLM و کاربرد آن در سرعتبخشی و کاهش مصرف حافظه است و ادغام vLLM با LangChain و استفاده از آن در RAG و Agentها در محیط پروداکشن (Production environment) را پوشش میدهد. استفاده از vLLM برای اجرای بهینه در محیط پروداکشن معمولاً مقدمهای بر سرویسدهی یا هاست کردن مدلها محسوب میشود.

6. چرا در این دوره به جای زنجیرههای ساده، از LCEL (زبان بیانی لنگچین) استفاده میشود؟

LCEL به جای زنجیرههای ساده استفاده میشود زیرا امکان ساخت جریانهای کاری پیچیده و Modular را با ترکیب آسان مؤلفهها فراهم میکند. این زبان بیانی، مدیریت ورودیها با تمپلیتهای پویا، پردازش خروجی به فرمتهای ساختاریافته مانند JSON و اجرای موازی یا شرطی تسکها را تسهیل میکند. همچنین، یکپارچهسازی قابلیتهایی مانند حافظه مکالمات و ابزارها را پشتیبانی کرده و توسعه برنامههای مقیاسپذیر و قابل نگهداری را ممکن میسازد.

7. تفاوت جستجوی Similarity ساده با روش MMR در سیستمهای RAG چیست؟

جستجوی Similarity ساده، اسناد را صرفاً بر اساس نزدیکی امبدینگ به پرسش کاربر بازیابی میکند که ممکن است به نتایج تکراری یا کمتنوع منجر شود. در مقابل، روش MMR (Maximal Marginal Relevance) علاوه بر شباهت، معیار تنوع را نیز لحاظ میکند تا اسناد بازیافتی، اطلاعات تکراری کمتری داشته و جنبههای مختلف پرسش را پوشش دهند. این امر کیفیت پاسخهای تولیدشده را با کاهش افزونگی و افزایش اطلاعات مفید بهبود میبخشد.

8. چگونه خروجی مدلهای زبانی را به فرمتهای ساختاریافته مثل JSON محدود میکنیم؟

برای محدود کردن خروجی مدل به فرمتهای ساختاریافته مانند JSON، از ابزارهایی مانند Output Parsers در LangChain استفاده میشود. این تبدیلکنندهها با تعریف قالبهای از پیش تعیینشده (مثلاً با استفاده از Pydantic) و ترکیب آنها با Prompt Templates، مدل را وادار میکنند تا دادهها را مطابق ساختار موردنظر تولید کند. سپس، خروجی مدل بهصورت خودکار به JSON یا دیگر فرمتها تبدیل و اعتبارسنجی میشود.

9. ایجنتهای هوشمند (Agents) چه تفاوتی با زنجیرههای معمولی (Chains) دارند؟

زنجیرههای معمولی دنبالهای ثابت از عملیات را اجرا میکنند، در حالی که ایجنتها توانایی تصمیمگیری پویا و استفاده از ابزارهای خارجی (مانند موتورهای جستجو) را دارند. ایجنت بر اساس ورودی کاربر، مسیر مناسب را انتخاب کرده و میتواند چندین عمل را بهصورت تکراری انجام دهد تا به نتیجه برسد. این انعطاف، ایجنتها را برای وظایف پیچیدهتر مانند تحلیل دادههای پویا یا تعامل با محیط ایدهآل میکند.

10. معماری چند ایجنتی (Multi-Agent) در CrewAI چه کاربردی در پروژههای واقعی دارد؟

معماری چند ایجنتی در CrewAI با توزیع مسئولیتها بین ایجنتهای تخصصی، وظایف پیچیده را به بخشهای کوچکتر تقسیم میکند. برای مثال، در پروژه نوشتن داستان، یک ایجنت طرح داستان را میریزد، دیگری شخصیتها را توسعه میدهد و ایجنتی دیگر متن نهایی را ویرایش میکند. این همکاری باعث افزایش کارایی، کاهش خطا و خروجی باکیفیتتر در سناریوهای واقعی مانند برنامهریزی یا تحلیل میشود.

11. مدلهای Multimodal (چندرسانهای) در محیط آفلاین چگونه پیادهسازی میشوند؟

پیادهسازی مدلهای چندرسانهای در محیط آفلاین با استفاده از ابزارهایی مانند Ollama و Hugging Face انجام میشود. برای پردازش تصویر، مدلهایی مانند LLaVA مستقیماً روی دستگاه نصب شده و تصاویر را تحلیل میکنند. برای ویدیو، از کتابخانههایی مانند Whisper برای تبدیل گفتار به متن و استخراج دادهها استفاده میشود. این مدلها بهصورت محلی اجرا شده و نیازی به اتصال اینترنت ندارند.

12. آیا امکان شخصیسازی رابط کاربری چتبات برای شبیهسازی تجربه ChatGPT وجود دارد؟

بله، با استفاده از فریمورک Streamlit میتوان رابط کاربری چتباتی مشابه ChatGPT ایجاد کرد. این رابط قابلیت نمایش تاریخچه مکالمات، پشتیبانی از حالت Streaming برای شبیهسازی تایپ واقعزمان و یکپارچهسازی با مدلهای محلی (مانند Ollama) را دارد. همچنین، با مدیریت State sessions، مکالمات ذخیره شده و تجربه کاربری روان و جذاب فراهم میشود.

سوالات متداول دوره ساخت چتبات فارسی کاملا آفلاین

1. پخش لایو (زنده) دوره به چه صورت است؟

ما با استفاده پلتفرم لحظه نگار پخش زنده را خواهیم داشت. شما در این پلتفرم محیط کلاس، صدا و دسکتاپ مدرس را بصورت زنده تماشا خواهید کرد.

2. پلتفرم «لحظهنگار» چیست؟

لحظهنگار یک پلتفرم پخش وبینار و کلاس های آنلاین است؛ لحظهنگار ابزاری جامع برای مدیریت و اجرای رویدادهای آنلاین با تمرکز بر سرعت و کیفیت بالا است. تمرکز اصلیاش ثبت رویدادها، تحلیلها یا روایتها به شکل زنده یا مرحلهبهمرحله است.

3. افرادی که بصورت لایو کلاس را مشاهده میکنند، آیا امکان پرسش و پاسخ دارند؟

شما بصورت چت آنلاین می توانید سوالات خود را بپرسید و مدرس هم سوالات شما را پاسخ خواهد داد. البته توجه داشته باشید که این پروسه پاسخگویی هر ۴۰ دقیقه یکبار خواهد بود تا مدرس رشته کلام از دستش خارج نشود. البته که گروه تلگرامی دوره در اختیار شما است و می توانید سوالات خود را آنجا هم مطرح کنید.

4. آیا داشتن لپ تاپ در کلاس اجباری است؟

بله. شما برای شرکت در کلاس و نصب نرم افزارهای مورد نیاز (اعلان خواهد شد) باید با خود لپ تاپ همراه داشته باشید.

5. آیا فیلم دوره رکورد می گردد؟

بله، دسکتاپ و صدای مدرس رکورد خواهد شد و در پلیر اختصاصی اسپات پلیر به همراه کلید لایسنس ارائه خواهد شد. شما در سیستم عاملهای ویندوز، اندروید، آیفون (سیب، اناردون)، مک بوک میتوانید فیلم را مشاهده کنید.

6. آیا پس از پایان دوره مدرک معتبری ارائه میشود؟

بله، پس از اتمام دوره و گذراندن آزمون پایانی، گواهی معتبری به شما ارائه میشود که میتوانید آن را در رزومه خود ثبت کنید.

7. آیا خرید اقساطی امکانپذیر است؟

بله، امکان خرید اقساطی با اسنپ پی فراهم شده است. برای اطلاعات بیشتر میتوانید با مشاورین مجموعه در تماس باشید یا راهنمای خرید اقساطی دوره آموزشی با اسنپ پی را مطالعه بفرمایید.