نحوه برگزاری دوره: آنلاین

دوره Data Lakehouse مقدماتی

اطلاعات دوره

معرفی دوره

معماری Data Lakehouse بهعنوان یکی از جدیدترین رویکردهای مدیریت و پردازش داده، امروز به یک مهارت کلیدی در حوزه بیگ دیتا و تحلیل دادههای مقیاسپذیر تبدیل شده است. این معماری با ترکیب مزایای Data Lake و Data Warehouse، امکان ذخیرهسازی، پردازش و تحلیل دادهها را با هزینه کمتر و انعطافپذیری بالاتر فراهم میکند و توسط شرکتهای پیشرو جهان مانند Netflix و Uber مورد استفاده قرار میگیرد. با توجه به رشد سریع دادهمحوری در کسبوکارها، معماری Lakehouse به هسته اصلی زیرساختهای داده در سازمانهای ایرانی نیز تبدیل شده است. دوره جامع Data Lakehouse با هدف ورود عملی به دنیای معماری مدرن داده و زیرساختهای پیشرفته طراحی شده است. در این دوره از مفاهیم پایه Data Lake و Data Warehouse تا طراحی و پیادهسازی یک سیستم Lakehouse واقعی آموزش داده میشود. شما با ابزارها و تکنولوژیهای مهمی مانند Apache Spark، Delta Lake، Kafka، Airflow، ذخیرهسازی ابری و پردازش آشنا شده و مهارت ساخت پایپلاینهای داده در مقیاس سازمانی را کسب میکنید. تمامی مباحث در قالب پروژههای واقعی و سناریوهای کاربردی ارائه شده تا شما بتوانید پس از پایان دوره وارد بازار کار مهندسی داده و بیگ دیتا شوید. این دوره بهصورت حرفهای و پروژهمحور در نیک آموز ارائه میشود.

دسترسی همیشگی به محتوا دوره

همه کلاسها ضبط میشوند و در هر زمان برای تمامی دانشجویان، چه آنلاین و چه حضوری، در دسترس خواهند بود!

پشتیبانی مستمر

در گروه اختصاصی دوره، پاسخ سؤالاتتان را بگیرید، پیشتیبانی دریافت کنید و با دیگر شرکتکنندگان در ارتباط باشید!

مدرک معتبر پایان دوره

با تکمیل دوره، مدرک پایان دوره دریافت کنید و مهارتهای خود را رسمی کنید!

گروه پرسش و پاسخ

سوال بپرسید، تجربه به اشتراک بگذارید و از دیگران یاد بگیرید، همه در یک فضای آموزشی فعال!

محتوای کاربردی، یادگیری موثر

هر آنچه میآموزید، مستقیماً در پروژهها و کار واقعی قابل استفاده است!

جلسه اول رایگان

اولین جلسه را بهصورت آنلاین و رایگان تجربه کنید، سپس با خیال راحت برای ادامه مسیر تصمیم بگیرید!

این دوره برای چه افرادی مناسب است؟

دوره جامع Data Lakehouse برای افرادی طراحی شده است که میخواهند وارد حوزه معماری مدرن داده، بیگ دیتا و زیرساختهای پیشرفته تحلیل داده شوند. اگر به دنبال یادگیری مهارتهای بهروز و موردنیاز بازار کار داخلی و بینالمللی هستید، این دوره میتواند مسیر شغلی شما را متحول کند.

✔ مهندسان داده (Data Engineers)

افرادی که در حوزه مهندسی داده فعالیت میکنند و قصد دارند دانش خود را در زمینه معماریهای جدید مانند Lakehouse، ارتقا دهند.

✔ تحلیلگران داده و متخصصان BI

تحلیلگران داده، متخصصان هوش تجاری و افرادی که با دادههای سازمانی کار میکنند و میخواهند با زیرساختهای مدرن ذخیره و پردازش داده آشنا شوند.

✔ توسعهدهندگان بکاند و برنامهنویسان

برنامهنویسانی که قصد دارند وارد حوزه بیگ دیتا، پردازش دادههای حجیم و سیستمهای مقیاسپذیر شوند و مهارتهای خود را در سطح بینالمللی ارتقا دهند.

✔ متخصصان حوزه کلود و DevOps

افرادی که در حوزه Cloud، زیرساخت و DevOps فعالیت میکنند و میخواهند معماری داده مدرن و ابزارهای مرتبط با آن را یاد بگیرند.

✔ علاقهمندان به هوش مصنوعی و یادگیری ماشین

کسانی که میخواهند زیرساخت داده مناسب برای پروژههای AI و Machine Learning را بشناسند.

✔ افرادی که به دنبال مهاجرت یا کار ریموت هستند

با توجه به رشد جهانی این حوزه، یادگیری Data Lakehouse میتواند فرصتهای شغلی بینالمللی و درآمد دلاری را فراهم کند.

مفاهیمی که یاد خواهید گرفت

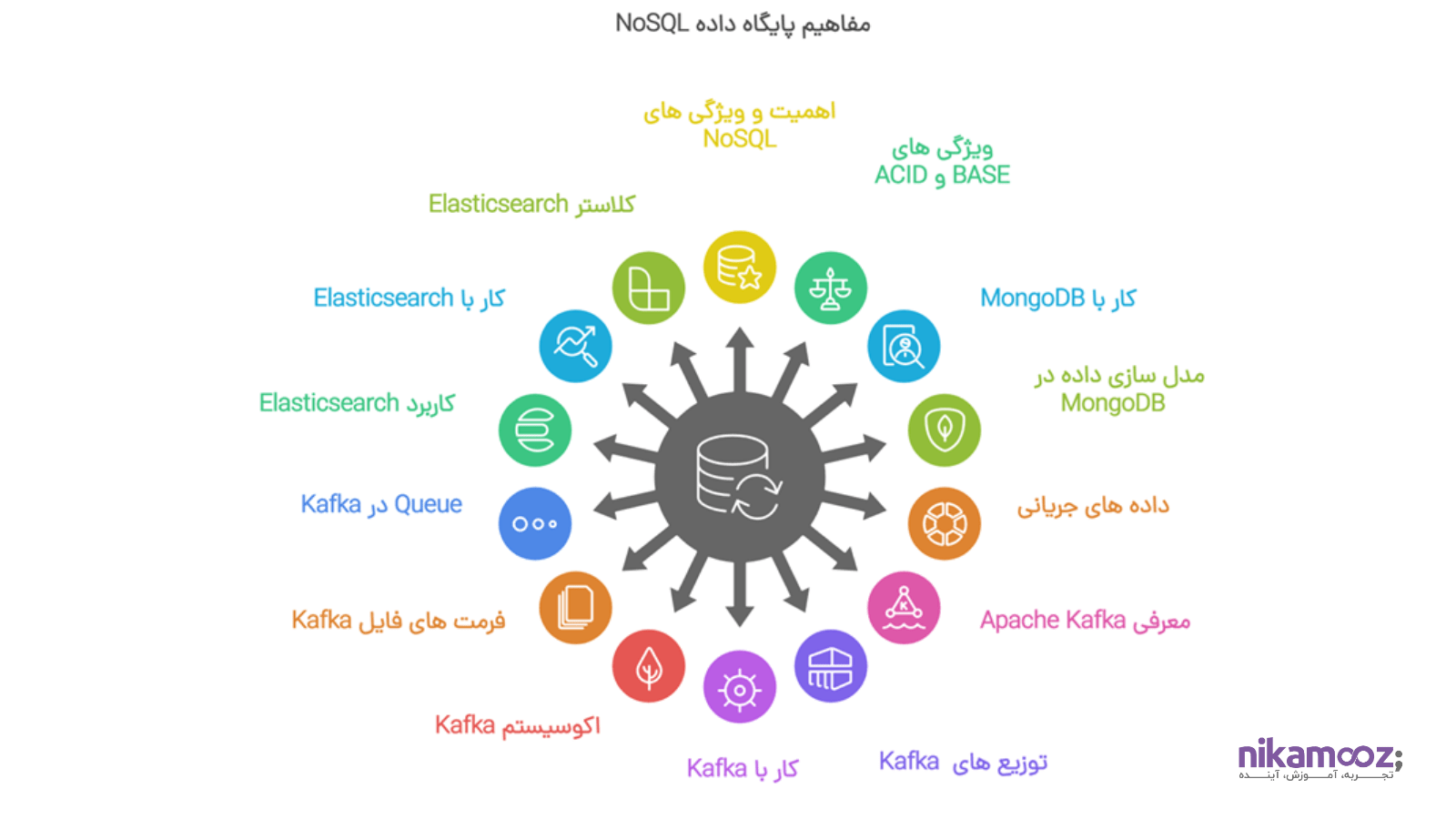

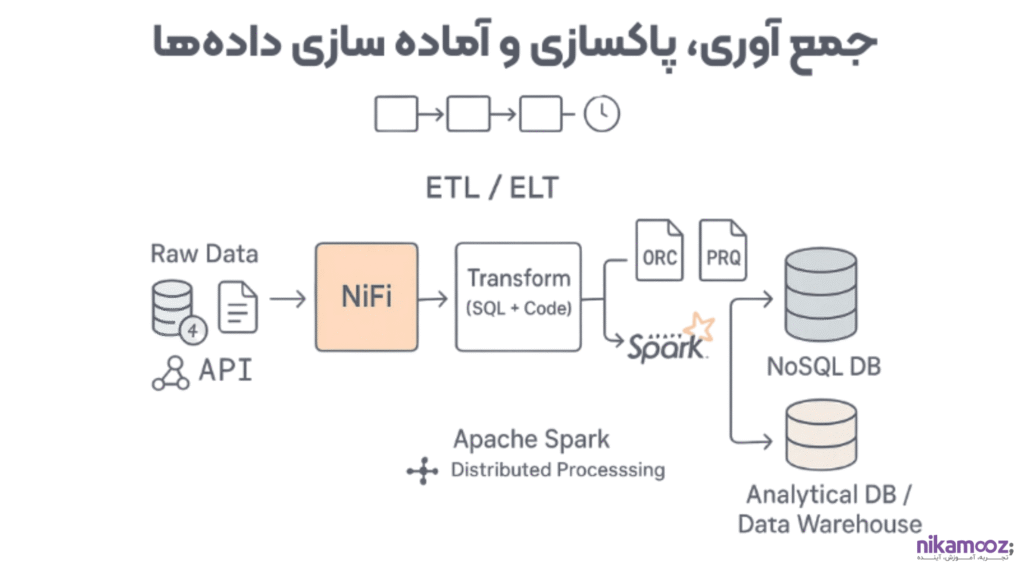

در این دوره با مفاهیم کلیدی مهندسی داده آشنا میشوید؛ از نقش مهندس داده در اکوسیستم بیگ دیتا، تا اصول کار با لینوکس و آشنایی اولیه با زبانهای مورد استفاده در پردازش داده. سپس با پایگاههای داده NoSQL، دادههای جریانی و پلتفرمهایی مانند Apache Kafka و Elasticsearch آشنا میشود و در ادامه، مفاهیمی مانند ETL و ELT، جمعآوری، پاکسازی و آمادهسازی دادهها و کار با ابزارهایی نظیر Apache NiFi ،Apache Spark و Airflow را در قالب سناریوهای کاربردی تمرین میکنید.

مدرس دوره

- معمار کلان داده در ایرانسل از ۱۴۰۰ تا کنون.

- مشاور مهندسی داده در تکنولایف از 1403.

- مشاور مهندسی داده در زپ از 1402.

- مدرس کلان داده و NoSQLها از سال ۱۳۹۷ تاکنون.

- معمار کلان داده در داتین از ۱۳۹۹ تا ۱۴۰۰.

- مهندس ارشد داده و Oracle DBA در شرکت پژواک از ۱۳۹۴ تا ۱۳۹۸.

- مشاور اوراکل در بیمه ایران از ۱۳۹۵ تا ۱۳۹۶.

- برنامه نویس جاوا و مهندس داده در ایزایران از 1393 تا 1394

- برنامه نویس جاوا در شرکت پژواک از 1389 تا 1393

سرفصلهای دوره

این سرفصلها چهارچوب اصلی دوره «Data Lakehouse» را مشخص میکنند و بر اساس نیازهای شغلی واقعی و فناوریهای روز در حوزه بیگ دیتا و پردازش توزیعشده طراحی شدهاند.

در طول دوره، علاوه بر مباحث اصلی، دهها نکته کلیدی و سناریوی عملی مبتنی بر ابزارهایی مانند Linux ,Python/Java ,NoSQL ,Kafka ,Spark ,NiFi و Airflow بهصورت کاملاً کاربردی آموزش داده خواهد شد.

1– ورود به دنیای Data Lakehouse

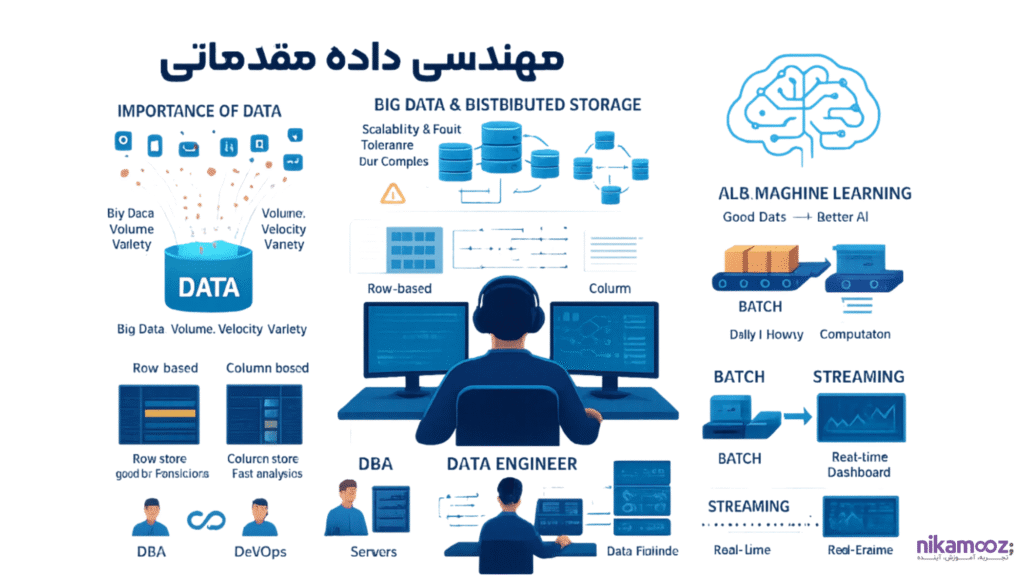

این فصل به عنوان دروازه ورود به دنیای مهندسی داده، اهمیت فزاینده دادههای حجیم و متنوع (بیگ دیتا) و چالشهای ناشی از ذخیرهسازی و پردازش آنها را بررسی میکند. در این بخش، شما با مسیر شغلی مهندس داده، تفاوتهای آن با نقشهایی مانند DBA و DevOps، و نقش حیاتی این تخصص در عصر هوش مصنوعی آشنا خواهید شد. همچنین، مفاهیم کلیدی مانند ذخیرهسازی و پردازش توزیعشده و مقایسه مدلهای ذخیرهسازی سطری و ستونی و مدلهای پردازشی Batch و Streaming به منظور ایجاد یک دیدگاه جامع از اکوسیستم دادههای مدرن، معرفی میشوند.

- مروری بر اهمیت داده، پایگاه داده و سیستم های ذخیره سازی

- مهمترین نیازمندی های لازم برای متخصصان مهندسی داده: مسیر حرفه ای شدن

- یک روز کاری مهندس داده چگونه است

- تفاوت ها و شباهت های نقش های مهندسی داده و DBA و DevOps

- عصر AI و اهمیت مهندسی داده

- بیگ دیتا چیست و چه کسانی بیگ دیتا دارند؟

- چالش های داده های حجیم و متنوع و بیگ دیتا

- ذخیره سازی توزیع شده، اهمیت و چالش های آن

- پردازش توزیع شده، اهمیت و چالش های آن

- مدل های ذخیره سازی سطری و ستونی و مثال هایی از آن

- مدل پردازشی Batch و Streaming

2– لینوکس برای مهندسان داده

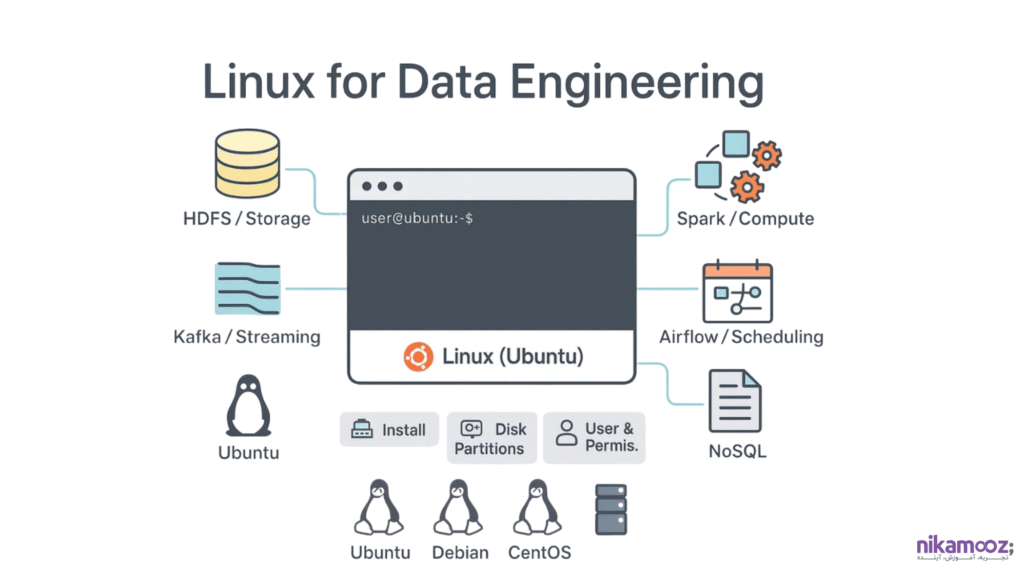

از آنجایی که اغلب پلتفرمها و ابزارهای بیگ دیتا و پردازش توزیعشده بر روی سیستمعامل لینوکس اجرا میشوند، تسلط بر آن برای مهندسان داده ضروری است. این فصل اهمیت لینوکس را در زیرساختهای دادهای توضیح میدهد و بر روی مهمترین توزیعها (مانند اوبونتو) متمرکز میشود. شما مهارتهای عملی مورد نیاز برای کار با لینوکس، از جمله نصب، مدیریت اولیه توزیعهای مختلف، تنظیمات شبکه و درک مفاهیم پارتیشنبندی و مدیریت دیسک را برای آمادهسازی محیطهای کاری دادهمحور، فرا خواهید گرفت.

- اهمیت لینوکس

- توزیع های مهم لینوکس

- نصب و کار با Ubuntu

- مروری بر تنظیمات شبکه، پارتیشن بندی و دیسک

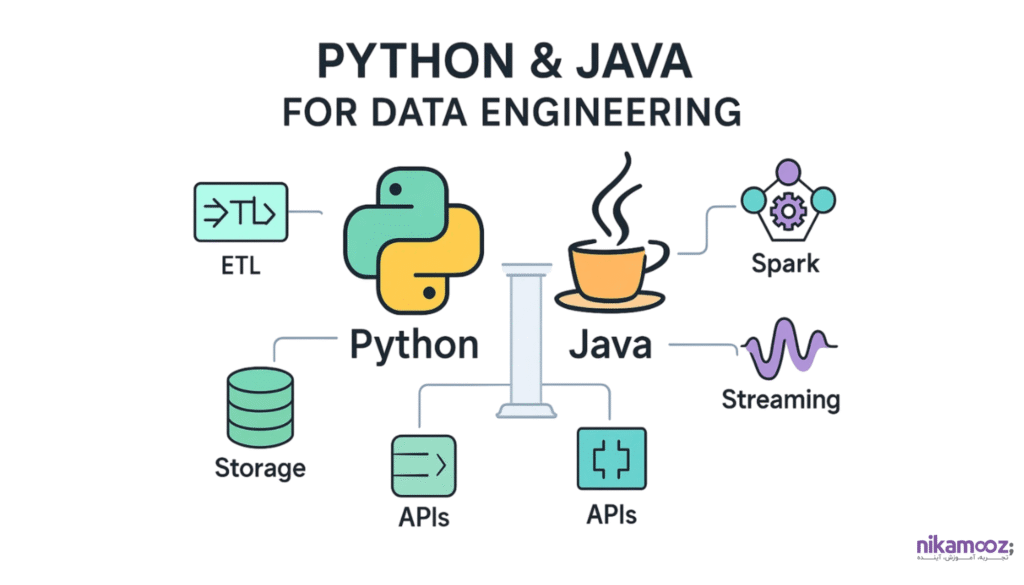

3–مقدمه ای بر جاوا و پایتون برای مهندسان داده

این سرفصل به معرفی و بررسی دو زبان برنامهنویسی پایتون و جاوا به عنوان ستونهای اصلی ابزارهای مهندسی داده میپردازد. این بخش بر تفاوت مهارتهای برنامهنویسی مورد نیاز مهندس داده در مقایسه با مهندس نرمافزار تأکید دارد، در حالی که نکات و اصطلاحات مهم طراحی نرمافزار را جهت توسعه کدهای پایدار و بهینه، آموزش میدهد. بخش عملی شامل کدنویسی و اجرای سناریوهای رایج پردازش داده با هر دو زبان و همچنین استفاده از گیت برای کنترل نسخه کدها و مدیریت پروژهها خواهد بود تا شرکتکنندگان آمادگی لازم برای کار با فریمورکهای مختلف دادهای را کسب کنند.

- زبان های برنامه نویسی مهم برای مهندسان داده

- آیا مهندس داده باید به خوبی یک مهندس نرم افزار در طراحی و برنامه نویسی باشد؟

- نکات و اصطلاحات مهم طراحی و توسعه نرم افزار برای مهندسان داده

- کار با گیت

- کد نویسی و انجام سناریوهای مختلف پردازش داده با پایتون

- کد نویسی و انجام سناریوهای مختلف پردازش داده با جاوا

4-پایگاه داده ها و پلتفرم های NoSQL و Stream Storage

این فصل بر تنوع و اهمیت پایگاههای داده NoSQL تمرکز دارد، ویژگیهای آنها را در مقابل مدلهای سنتی ACID بررسی کرده و مفاهیمی مانند BASE را توضیح میدهد. بخش عملی شامل کار با پایگاه داده MongoDB و اصول مدلسازی داده در آن است. در ادامه، مبحث دادههای جریانی (Stream Data) و چالشهای آن معرفی میشود و پلتفرم Apache Kafka به عنوان ابزار اصلی ذخیرهسازی جریانی، ساختار، کاربردها و مؤلفههای آن (مانند Kafka Connect) مورد بررسی قرار میگیرد. در نهایت، معماری و نحوه کار با Elasticsearch برای مدیریت و جستجوی دادههای حجیم به عنوان یک ابزار قدرتمند تحلیلی، آموزش داده میشود.

- اهمیت، ویژگی ها و علت تنوع پایگاه داده های NoSQL

- ویژگی های ACID و BASE در پایگاه داده های NoSQL

- کار با MongoDB

- مدل سازی داده در مانگو دی بی و نکات مدل سازی

- داده های جریانی، ویژگی ها و چالش های آن

- معرفی Apache Kafka و کاربرد و ویژگی های آن

- توزیع های مختلف کافکا و پلتفرم های سازگار با Protocol کافکا

- کار با کافکا و کامپوننت های کافکا مانند Kafka Connect

- اکوسیستم کافکا و انجام سناریو های مختلف ذخیره و بازیابی داده در کافکا

- فرمت های مختلف فایل برای کافکا

- Queue در کافکا

- کاربرد Elasticsearch و معماری آن

- کار با Elasticsearch

- کلاستر Elasticsearch و ساختار آن

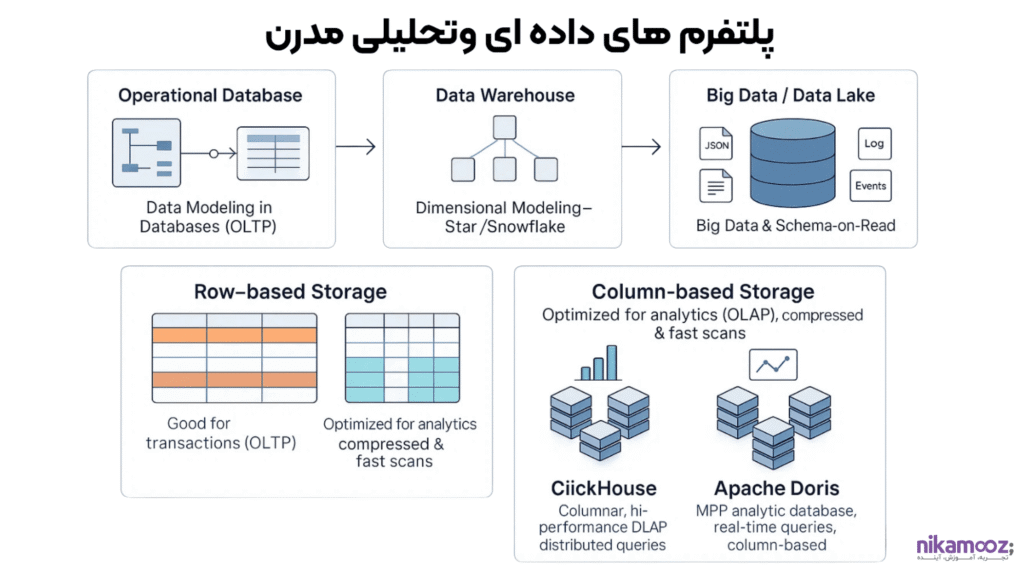

5-پلتفرم های داده ای و تحلیلی مدرن

این بخش به معرفی و کاربرد پلتفرمهای تحلیلی و انبارهای داده مدرن که برای پردازش و تحلیل کارآمد دادههای حجیم طراحی شدهاند، میپردازد. ابتدا مفاهیم مدلسازی داده در انبار داده و تفاوتهای کلیدی بین ذخیرهسازی Row-base و Column-base که سرعت کوئریها را تحت تأثیر قرار میدهند، مرور میشوند. سپس، شرکتکنندگان با پلتفرمهای ستونی با کارایی بالا مانند ClickHouse و Apache Doris آشنا میشوند و نحوه کار، ویژگیها و مزایای استفاده از آنها در محیطهای تحلیلی پیچیده برای ارائه گزارشگیریهای سریع و پاسخگویی به کوئریهای تحلیلی را فرا میگیرند.

- مدل سازی داده در دیتابیس، انبار داده و بیگ دیتا

- تفاوت ذخیره سازی Row-base و Column-base

- کار با ClickHouse و ویژگی های کلیک هاس

- کار با Doris Apache و ویژگی های دوریس

6-جمع آوری، پاکسازی و آماده سازی داده ها

این فصل هسته اصلی کار یک مهندس داده را تشکیل میدهد و فرآیندهای حیاتی ETL و ELT و اهمیت کیفیت داده را پوشش میدهد. این بخش بر روی پیادهسازی عملی سناریوهای آمادهسازی دادهها با استفاده از دستورات SQL و یک زبان برنامهنویسی تمرکز میکند. همچنین، استفاده از ابزارهای خاصی مانند Apache NiFi برای طراحی Data Flowهای جمعآوری داده و Apache Spark به عنوان یک فریمورک پردازش توزیعشده مقیاسپذیر برای اجرای سناریوهای مختلف Spark SQL و خواندن/نوشتن در منابع دادهای NoSQL و تحلیلی آموزش داده میشود. در پایان، مفاهیم مربوط به فرمتهای بهینه ذخیرهسازی مانند ORC و Parquet و روشهای Scheduling تسکهای دادهای با استفاده از ابزارهایی مانند Airflow بررسی خواهند شد.

- ETL و ELT

- کیفیت داده و معیار های آن

- پیاده سازی سناریو های مختلف آماده سازی داده به کمک یک زبان برنامه نویسی و دستورات SQL

- مقیاس پذیری درلایه پردازش و استفاده از روش های پردازش توزیع شده

- استفاده از Apache NiFi برای طراحی Data Flow های جمع آوری داده

- انجام سناریو های متنوع Ingestion در NiFi به پایگاه داده های NOSQL و تحلیلی

- مروری بر Apache Spark و قابلیت های آن

- انجام سناریو های مختلف پردازش داده در Spark SQL

- بررسی فرمت فایل های ORC و Parquet و مزایا و معایب آنها

- خواندن و نوشتن در منابع داده ای NoSQL و تحلیلی با آپاچی اسپارک

- روش های Scheduling تسک ها

- استفاده از Airflow برای Scheduling

چارچوب برگزاری دوره

فرایند برگزاری و زمانبندی

نوع ارائه و هزینه دوره آنلاین

ظرفیت باقیمانده: 15 نفر

امکان پرداخت 4 قسطه با

پلتفرم برگزاری: لحظهنگار

امکان معرفی برترینها به بازار کار

مشاهده دوره و پرسش و پاسخ آنلاین در بستر لحظهنگار

دسترسی آفلاین به ویدیوها در اسپاتپلیر

دانلود PDF پاورپوینت جلسات

دارای گروه پرسش و پاسخ تلگرامی

ظرفیت باقیمانده: 5 نفر

- بصورت آنلاین یا حضوری به مدت ٨ ساعت

- بررسی اختصاصی معماری مهندسی داده شما

- امکان رکورد جلسات توسط شما

پلتفرم برگزاری: لحظهنگار

امکان معرفی برترینها به بازار کار

مشاهده دوره و پرسش و پاسخ آنلاین در بستر لحظهنگار

دسترسی آفلاین به ویدیوها در اسپاتپلیر

امکان پرداخت 4 قسطه با

ثبت نام دوره آنلاین Data Lakehouse مقدماتی

اگر هنوز برای ثبتنام قطعی تصمیم نگرفتهاید اما میخواهید ظرفیت خود را حفظ کنید، فرم زیر را تکمیل کنید. با توجه به محدودیت ظرفیت، اولویت با افرادی است که زودتر رزرو خود را انجام دهند.

"*" فیلدهای الزامی را نشان می دهد

از تجربه تا نتیجه!

شرکتکنندگان این دوره از دانشجویان کلاسهای استاد ارومند هستند و نظرات واقعیشان را درباره سبک تدریس و کلاسها میگویند. تجربههایشان را بشنوید و با اطمینان تصمیم بگیرید!

نمونه مدرک نیک آموز

مدرک نیک آموز نشاندهنده تخصص و مهارتی است که شما را برای موفقیت در آزمونهای استخدامی و پروژههای حرفهای آماده میکند. همچنین، شما میتوانید پس از دریافت مدرک، آن را مستقیماً به بخش Education پروفایل لینکدین خود اضافه کرده و رزومه خود را معتبرتر کنید

نمونه آموزشها

ویدیوهای زیر، نمونههایی از سبک تدریس و کلاسهای استاد ارومند هستند. با مشاهده آنها میتوانید با نحوه آموزش ایشان آشنا شوید و با اطمینان بیشتری برای شرکت در دوره تصمیم بگیرید.

شرکت در جلسه اول آنلاین این دوره رایگان میباشد، جهت ثبتنام کلیک کنید.

سوالات تخصصی دوره Data Lakehouse مقدماتی

1. Data Lakehouse چیست؟

Data Lakehouse یک معماری مدرن داده است که قابلیتهای Data Lake و Data Warehouse را در یک بستر واحد ترکیب میکند. در این مدل، دادههای حجیم و متنوع بهصورت مقرونبهصرفه ذخیره میشوند و همزمان امکان انجام تحلیلهای ساختاریافته، گزارشگیری و پردازشهای پیشرفته روی همان دادهها فراهم است. این معماری (با حفظ کیفیت داده، امنیت و قابلیت اطمینان)، زیرساختی یکپارچه و مقیاسپذیر برای تحلیل داده و هوش مصنوعی ایجاد میکند.

2. چه پیشنیازهایی برای شرکت در این دوره نیاز است؟

برای ورود به این دوره، داشتن دانش کافی در زمینه SQL و تجربه کار با حداقل یکی از پایگاه دادههای رابطهای (RDBMS) ضروری است. از آنجایی که در طول دوره به مباحث برنامهنویسی و محیطهای عملیاتی پرداخته میشود. آشنایی اولیه با منطق برنامهنویسی به شما کمک میکند تا از فصلهای مربوط به پایتون، جاوا و لینوکس بیشترین بهره را ببرید.

3. مهندسی داده چیست و چه کسی مهندس داده است؟

منابع موجود به طور مستقیم تعریف جامعی از اینکه مهندسی داده چیست یا دقیقاً چه کسی مهندس داده است، ارائه نمیدهند. با این حال، این حوزه شامل بررسی اهمیت فزاینده دادههای حجیم و متنوع (بیگ دیتا)، چالشهای ذخیرهسازی و پردازش آنها و نقش حیاتی این تخصص در عصر هوش مصنوعی است.

4. آینده شغلی مهندسی داده به کدام سمت میرود؟

با انفجار حجم دادهها و ظهور عصر هوش مصنوعی نیاز به مهندسان داده بیش از هر زمان دیگری احساس میشود. آینده این شغل به سمت اتوماسیون فرآیندهای داده، استفاده از پلتفرمهای ابری و پردازشهای آنی (Real-time) در حرکت است. شرکتهای بزرگ جهان و ایران به شدت به دنبال متخصصانی هستند که بتوانند چالشهای بیگدیتا (Big Data) و پردازشهای توزیعشده را مدیریت کنند.

5. مهندس داده با مهندس نرم افزار چه تفاوتی دارد و چه پروژههایی این دو اجرا میکنند؟

در حالی که مهندس نرمافزار بر روی ساخت اپلیکیشن و تعامل با کاربر تمرکز دارد، مهندس داده بر روی جریان داده و کارایی سیستمهای ذخیرهسازی تمرکز میکند.

- مهندس نرمافزار: پروژههایی مثل طراحی وبسایت، اپلیکیشن موبایل یا سیستمهای فروش را پیش میبرد.

- مهندس داده: پروژههایی مثل طراحی انبار داده، ساخت پایپلاینهای ETL، مدیریت کلاسترهای بیگدیتا و بهینهسازی کوئریهای تحلیلی سنگین را اجرا میکند.

6. در اکوسیستم مهندسی داده، Apache Spark چیست و چه کاربردی دارد؟

Apache Spark قدرتمندترین فریمورک پردازش توزیعشده است. در این دوره، اسپارک به عنوان هسته اصلی پردازش معرفی میشود. کاربرد اصلی آن سرعت بخشیدن به تحلیل دادههای حجیم است (تا ۱۰۰ برابر سریعتر از روشهای سنتی). شما در این دوره نحوه استفاده از Spark SQL و خواندن و نوشتن دادهها در منابع مختلف NoSQL را به صورت عملی فرا میگیرید.

7. در این دوره کدام یک از NoSQLها کاربرد دارد؟

در این دوره، به صورت تخصصی بر روی دو مورد از محبوبترین و پرکاربردترین پایگاههای داده غیررابطهای تمرکز میکنیم:

- MongoDB: برای مدیریت دادههای سندمحور (Document-based).

- Elasticsearch: به عنوان یک موتور جستجو و تحلیل قدرتمند برای دادههای حجیم. همچنین تفاوتهای ساختاری ACID و BASE در این سیستمها به طور کامل بررسی میشود.

8. کافکا چیست؟ آیا در این دوره Kafka تدریس میشود؟

بله، کافکا پلتفرمی برای مدیریت جریان دادهها به صورت توزیعشده است. در این دوره، شما با معماری کافکا، کامپوننتهای آن مثل Kafka Connect و سناریوهای واقعی ذخیره و بازیابی داده در محیط کافکا آشنا خواهید شد.

9. ClickHouse چیست و چه کاربردی دارد؟

ClickHouse یک پایگاه داده ستونی (Column-oriented) بسیار سریع برای پردازشهای تحلیلی (OLAP) است. برخلاف دیتابیسهای سنتی که داده را سطری ذخیره میکنند، ClickHouse با ذخیرهسازی ستونی اجازه میدهد گزارشهای تحلیلی روی میلیاردها رکورد در کسری از ثانیه اجرا شوند. در این دوره، کار با این ابزار و رقیب آن یعنی Apache Doris را یاد خواهید گرفت.

10. تفاوت مدلهای ذخیرهسازی سطری (Row-based) و ستونی (Columnar) در چیست و چرا در این دوره روی دیتابیسهای ستونی تأکید شده است؟

در مدل ذخیرهسازی سطری، دادهها بهصورت رکوردهای کامل و پیوسته ذخیره میشوند که برای تراکنشهای عملیاتی (OLTP) مناسب است، زیرا بازیابی یا بهروزرسانی یک رکورد کامل سریع انجام میشود. در مقابل، در مدل ستونی، مقادیر هر ستون جداگانه ذخیره میشوند که امکان فشردهسازی بهینه و بازیابی سریع ستونهای خاص را فراهم میکند. این ویژگی باعث میشود دیتابیسهای ستونی برای پردازش تحلیلی (OLAP) و کوئریهای تجمیعی ایدهآل باشند، چرا که تنها دادههای مرتبط بارگذاری شده و حجم I/O کاهش مییابد. در دورههای مدرن، با رشد نیاز به تحلیل دادههای حجیم، دیتابیسهای ستونی مانند ClickHouse و Apache Doris بهدلیل کارایی بالا در پردازش کوئریهای پیچیده و گزارشگیری، مورد تأکید قرار گرفتهاند.

11. منظور از پردازش توزیعشده چیست و چگونه در لایه Ingestion و Processing پیادهسازی میشود؟

پردازش توزیعشده به تقسیم وظایف پردازشی بین چندین گره (Node) در یک شبکه اشاره دارد که امکان مقیاسپذیری، تحمل خطا و کارایی بالا را فراهم میکند. در لایه Ingestion، این مفهوم با ابزارهایی مانند Apache Kafka پیادهسازی میشود که دادهها را بهصورت جریانی و موازی بین چندین پارتیشن توزیع میکند. در لایه Processing، فریمورکهایی مانند Apache Spark از پردازش توزیعشده برای اجرای عملیات ETL/ELT استفاده میکنند و با تقسیم دادهها به بلوکهای کوچک، پردازش موازی روی کلاسترها را ممکن میسازند. این معماری چالشهای حجم بالای داده را با توزیع بار پردازشی حل میکند.

سوالات متداول دوره

1. پخش لایو (زنده) دوره به چه صورت است؟

ما با استفاده پلتفرم لحظه نگار پخش زنده را خواهیم داشت. شما در این پلتفرم محیط کلاس، صدا و دسکتاپ مدرس را بصورت زنده تماشا خواهید کرد.

2. پلتفرم «لحظهنگار» چیست؟

لحظهنگار یک پلتفرم پخش وبینار و کلاس های آنلاین است؛ لحظهنگار ابزاری جامع برای مدیریت و اجرای رویدادهای آنلاین با تمرکز بر سرعت و کیفیت بالا است. تمرکز اصلیاش ثبت رویدادها، تحلیلها یا روایتها به شکل زنده یا مرحلهبهمرحله است.

3. افرادی که بصورت لایو کلاس را مشاهده میکنند، آیا امکان پرسش و پاسخ دارند؟

شما بصورت چت آنلاین می توانید سوالات خود را بپرسید و مدرس هم سوالات شما را پاسخ خواهد داد. البته توجه داشته باشید که این پروسه پاسخگویی هر ۴۰ دقیقه یکبار خواهد بود تا مدرس رشته کلام از دستش خارج نشود. البته که گروه تلگرامی دوره در اختیار شما است و می توانید سوالات خود را آنجا هم مطرح کنید.

4. آیا داشتن لپ تاپ در کلاس اجباری است؟

بله. شما برای شرکت در کلاس و نصب نرم افزارهای مورد نیاز (اعلان خواهد شد) باید با خود لپ تاپ همراه داشته باشید.

5. آیا فیلم دوره رکورد می گردد؟

بله، دسکتاپ و صدای مدرس رکورد خواهد شد و در پلیر اختصاصی اسپات پلیر به همراه کلید لایسنس ارائه خواهد شد. شما در سیستم عاملهای ویندوز، اندروید، آیفون (سیب، اناردون)، مک بوک میتوانید فیلم را مشاهده کنید.

6. آیا پس از پایان دوره مدرک معتبری ارائه میشود؟

بله، پس از اتمام دوره و گذراندن آزمون پایانی، گواهی معتبری به شما ارائه میشود که میتوانید آن را در رزومه خود ثبت کنید.

7. آیا خرید اقساطی امکانپذیر است؟

بله، امکان خرید اقساطی با اسنپ پی فراهم شده است. برای اطلاعات بیشتر میتوانید با مشاورین مجموعه در تماس باشید یا راهنمای خرید اقساطی دوره آموزشی با اسنپ پی را مطالعه بفرمایید.